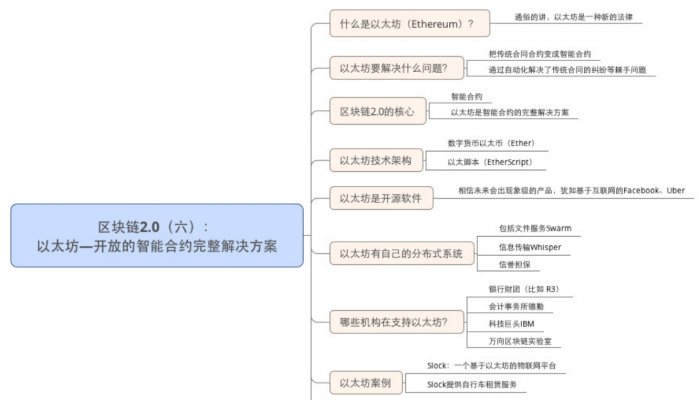

图片生成模型

图像生成模型是将输入图像编码为一组参数,然后用这组参数生成新的图像的方法。基本步骤包括:

(1)图像输入:使用浅层神经网络或深度神经网络对输入图像进行编码,以将输入图像信息转化为参数或特征向量。

(2)解码:使用生成器网络对每个参数或特征向量进行解码,以重新构造图像。

(3)无监督分类:使用无监督分类方法将生成的图像分为不同类别,以降低网络对训练数据的偏差。

(4)最小化损失:使用损失函数最小化网络在输入和输出之间的差异,以改进图像生成器模型的质量。

(5)生成优化:优化图像生成器网络,使其能够以更少的步骤达到更好的效果。

图像生成模型可以用来帮助人们了解更多有关图像内容的信息,并可以帮助机器学习的应用,如图像分类和图像生成等。此外,图像生成模型还可以应用于生成新的图像,例如使用新的文本和其他图像,或使用给定的图像和文本匹配特定的图像,这些都是使用图像生成模型的有效应用。

突然间,AI 文字转图片成为了全球科技业的一大流行技术趋势。

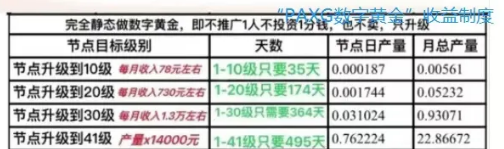

几周前我们报道了“新一代梗图之王” DALL·E mini,一个脑洞十分清奇的文字转图片 AI 小工具。当时我们也提到, 包括谷歌、OpenAI 等大公司和顶级研究机构都在开发相关模型,就连时尚杂志《COSMO》都采用 AI 来设计杂志封面。

图片来源:COSMO 杂志

然而令许多人没想到是:

就在各家硅谷大厂斥巨资研发、砸了无数的人力、发了无数的论文,却还在测试相关技术的时候,TikTok 居然异军突起,首先把 AI 文字转图片做到了产品里,而且直接交到了全球十亿用户的手上……

乱拳打死老师傅,中国速度太快了

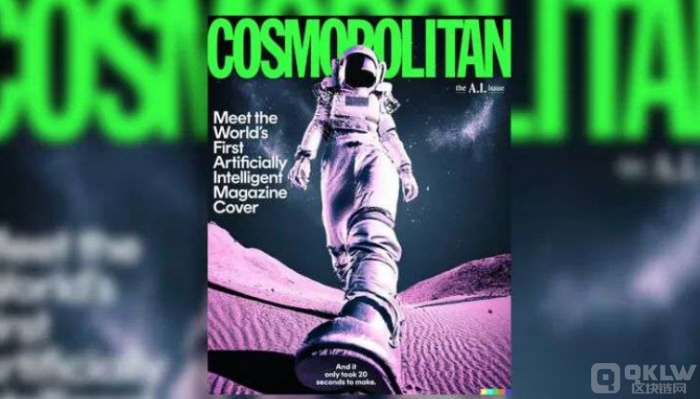

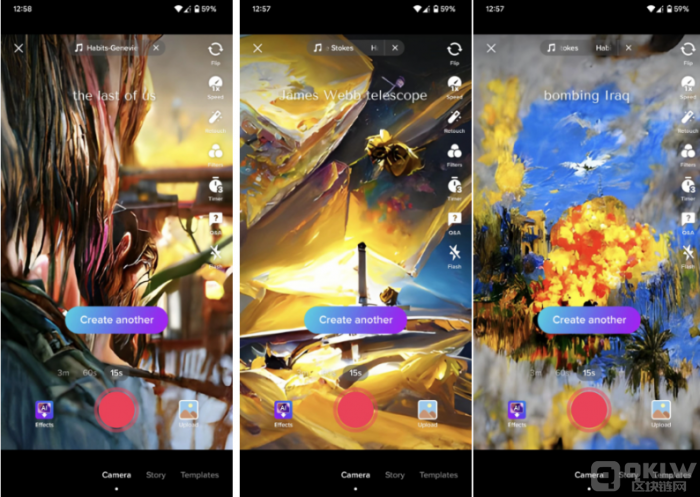

在 TikTok 的特效菜单下,最近增加了一个名叫“AI 绿幕” (AI Greenscreen) 的新选项。

点击这个选项,然后在屏幕中间的对话框里输入一段文字描述,只用不到5秒的时间,TikTok 就可以根据文字描述生成一张竖版画作,用作短视频的背景:

图片来源:硅星人截图

TikTok 用的这个文字转图片模型,还是非常简单的。 硅星人测试了几个含义大相径庭的提示,生成的图片可以说都十分的“迷幻",没有任何写实色彩。

但这并不是缺点缺点——正相反,生成结果具有 非常强的水彩/油画感觉,风格迁移 (style transfer) 的痕迹明显,而且用的颜色也都鲜亮明快,给人一种耳目一新的感受。

图片来源:TechCrunch 截图

我特别想单独说一下我自己生成的两张图片:

下图左边的提示字段是知名游戏“最后生还者”。生成结果的辨识度太高了,这不正是游戏主角 Ellie 被泥浆血水浸湿的头发吗?

右图更有意思,提示是“轰炸”:我完全没有想到如此“不和谐”的字段,TikTok 的模型居然生成的结果却相当的“自洽”,特别是图中的“轰炸机”反而看起来像是代表和平的“白鸽”——是否你也能读出一点讽刺的意味?

图片来源:硅星人截图

当然话说回来,这些只是我自己的解读和感受,绝不可能是模型的“本意”。但是有趣的艺术作品不正应该是这样嘛,让人能够发现一些巧妙的“彩蛋”,甚至浮想联翩,解读出另外的含义。

从这一角度,我还是非常认可 TikTok 目前部署的这个模型的。

模型的质量也值得一提。The Verge、TechCrunch 等美国媒体测试了一些特殊的敏感字段,AI 绿幕生成结果更加抽象了,显示出字节部署的模型在争议字段上可能已经做出了提前规避。

要知道 AI 文字生成图片本来就不是简单的技术,避免争议/道德风险更是一项相当复杂的工作。

图片来源:The Verge 截图

正如文章前面提到,谷歌、OpenAI 等巨头公司和知名机构开发的 AI 文字生成图片模型,目前都处于刚刚发布或者小范围测试,还在“纸上谈兵”的阶段。

这边 TikTok 不仅很快跟进推出了同类模型,更厉害的是已经将其投放到全球十亿用户量级别的产品里了。

本来以为 AI 艺术创作的潮流还是几个硅谷大厂在引领,没想到字节跳动居然“乱拳打死老师傅”——必须给中国互联网科技公司的工作速度和质量点赞了。

AI创作成潮流,硅谷大厂挤破头

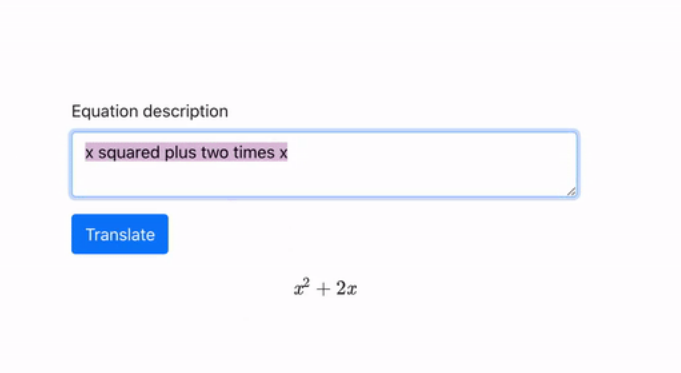

早在2020年,全球知名的人工智能基础科研机构 OpenAI 发布了一个名为 GPT-3 语言模型。 当时 OpenAI 的论文题为“Language Models are Few-Shot Learners ” ,直接点出了超大规模语言模型在多种非训练人物上具备强大、快速的学习和掌握能力。

GPT-3 也完全没令人失望 ,在小 范围开放 测 试 A PI 之 后, 外界人士用它开发出了各种各样神奇的 demo,展示了写段子、翻译公式、解数学题、完成用户界面设计、生成财务报表等能力。

“AI 文字生成图片” 也是这些能力的其中一项。

图片来源:硅星人

包括 O pen AI、谷歌、 Midjourney、Stability AI 等一众 大小 公司 ,已经开发出了多个 文字转图片生成模型,展示出神经 网络模型具备令人惊讶的艺术创作能力。

从 AI 文字转图片生成技术开始得到公众关注,到今天各路大厂和小公司挤破头也要掺和,各种不开放的、开放的、收费和免费的模型层出不穷……也就过去了一年左右的时间。

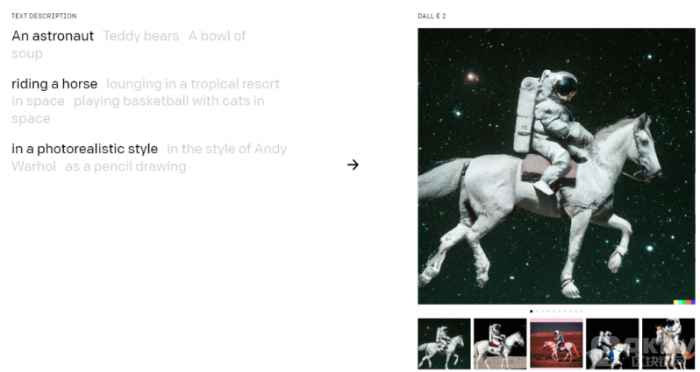

在这些模型当中,OpenAI 的 DALL·E 是最著名的一款。该模型一代于2021年推出,今年刚刚更新到了二代。用户只需提供自然语言描述,模型就能够生成非常写实 (photorealisitic) 的图片。

图片来 源:OpenAI

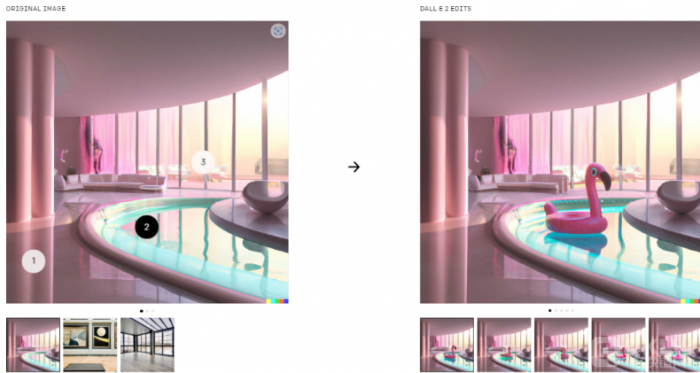

除了从零开始生成全新照片,DALL·E 2 还有更多功能,适合现实中多种艺术工作场景。

比如它的编辑能力,可以在一张已经存在的照片中,在用户任选的位置“删除”或者“添加”物体,并且编辑后的效果仍然很写实:

图示:在照片的不同位置添加“火烈鸟”。图片来 源:OpenAI

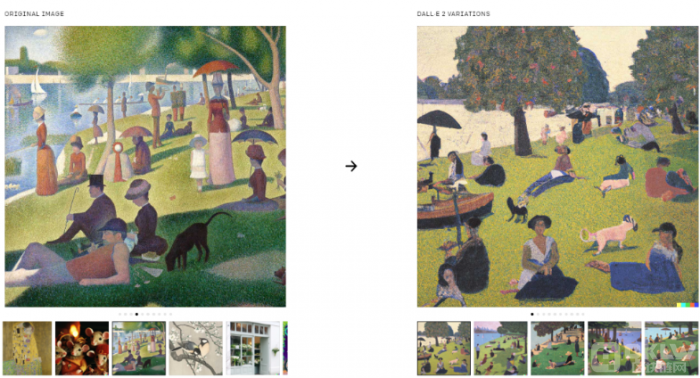

再比如 DALL·E 2 还具备“启发”的能力,能够根据一张已经给定的图片,生成风格近相同的新照片:

图片来 源:OpenAI

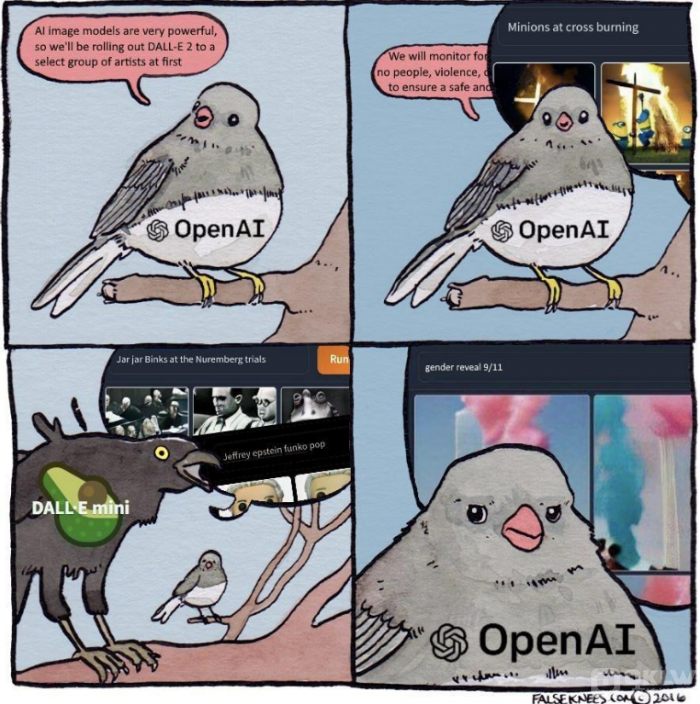

顺便一提:有个跟 OpenAI 没关系的第三方开发者,自己仿着 DALL·E 做了一个图片生成模型,还给免费开放了,取名为 DALL·E mini。

结果这个“仿制品”比正品还受欢迎,在社交网络 Twitter 上专门搬运这个模型生成的奇怪图片的账号,粉丝量都破了百万。甚至逼得 OpenAI 专门出来澄清跟它没关系,要求开发者做出改变。现在这个免费小工具已经改名为 Craiyon 了。

(听说此事之后,粉丝们还做了一张梗图,嘲笑 OpenAI 那边还在控制测试权限,这边 DALL·E mini 早就给全网玩嗨了……)

图片来 源:FALSEKNEES

而在硅谷大厂的行列当中,现在谷歌是已知动作最快的,在 DALL·E 2 出来不久后也发布了自己的模型,名为 Imagen。

就像 DALL·E 的根源是语言超大模型 GPT-3,Imagen 的根源也是谷歌开发的泛用型超大语言模型 T5。至于 Imagen 的这个命名,其实是图片 (image) +生成 (generate) 的混成词。

图片来 源:Google Research

虽然做的比 DALL·E 晚,同样作为硅谷知名 AI 研究型公司的谷歌,还是非常不服 OpenAI 的,宣称找人做了一堆同类模型的盲测,结果是受试者更喜欢 Imagen 生成的结果,认为其在“生成质量”和“文字描述还原度”上都更胜一筹。

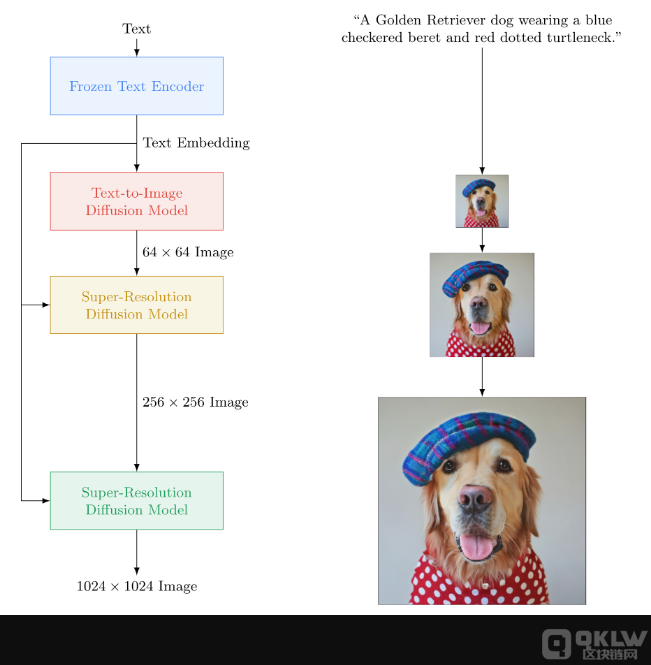

——当然,究竟是 DALL·E 2 和 Imagen 谁的生成结果更好,还是一个很主观的,见仁见智的事情。在技术实现上,这两家其实大同小异,都是用了 Diffusion(扩散)模型生成,然后再用 Super-Resolution(超分辨率) 技术来让生成结果更加清晰。

图片来源:Google Research

还有更多规模更小的新创公司也在做 AI 图片生成和艺术创作这件事。

其中一家比较有意思的公司就是 Midjourney,其创始人是原知名动作感应技术公司 Leap Motion 创始人 David Holz;公司的投资人和顾问团队更是相当强大,都是苹果、特斯拉、AMD、GitHub 等知名公司的核心人物。

Midjourney 跟 OpenAI、谷歌的写实方向背道而驰,而是在抽象、艺术性、独特风格之间寻求某种巧妙的结合点,这也是这家公司和其模型比较特别之处。另外 Midjourney 开放模型技术的做法也很“年轻化”,不是发布 API 和文档,而是把服务接口做到了聊天软件 Discord 里。

图片来源:Midjourney

说完这些比较知名的公司,再来看一家名不见经传,但是和 TikTok 一样出手极快的美国公司:Stability AI。

这家公司总部位于硅谷 Los Altos,在上周刚刚发布了一个可以免费使用的 AI 图片生成产品 Stable Diffusion。

图片来源:Stability AI

Stable Diffusion 和前面介绍的几个写实派模型没有太大不同。但是和产品、公司名称里的“稳定”正相反,这个模型在有害/争议字段的处理上,可以说完全没有任何作为。而又因为产品是完全免费提供给公众的,已经有很多用户用它制作 deepfake、暴力、恐怖主义、虚假新闻图片等有害的内容了……

最近大半年,AI 图片生成已经成为了一个名副其实的科技行业“热词”,只是没想到,Open AI 和谷歌做了这么多年,却被 TikTok 给悄无声息地跑赢了。接下来,应该会有更多的科技公司也参与其中,不少全民应用背后的大厂估计又要忙活着把这项技术加到产品中了。