GTX 20系列“煤气灶”实测,NVIDIA:高分辨率的未来市场在VR上

VR陀螺2018年8月21日,英伟达在德国科隆发布了新一代基于Turing架构的显卡:GeForce RTX 2080/2080Ti。预购RTX 2080及RTX 2080TI的朋友基本已经收到实物了,不知道各位对这一新的“煤气灶”是否满意?火力够不够旺?玩笑归玩笑。回到VR行业中,相信有不少观众对新显卡会有疑问,这新显卡对VR能有多大的作用?

借此契机,陀螺菌在广州天河NVIDIA RTX沟通会上采访到NVIDIA中国区技术市场经理朱亮,探讨GeForce RTX 20系列对VR开发带来的可能性。

“4K基本满足游戏竞技对屏幕的要求,分辨率(高分辨率的使用场景)的未来市场在VR上”,朱亮说道。

实时光线追踪+深度学习,把CG电影的效果用在游戏上

此处推出的新旗舰为GeForce RTX 2080Ti,次旗舰为GeForce RTX 2080,出人意料的是新显卡并没有使用坊间猜测的GTX 1180这一名称。此次的新品,NVIDIA不但将系列名称直接升到GeForce 20,而且舍去了延用十代的GTX这一前置,取而代之的是RTX。

RTX的名称的是由光线追踪Ray Tracing的两个首字母R和T组成,NVIDIA RTX所指的便是实时光线追踪技术。虽然名字听上去很厉害,但相较于全新的Turing架构,其名称的改动就显得微不足道。

由于Turing架构涉及过多专业性的技术,网上技术论坛已经有较为详细的分析,陀螺菌在此便不做过多的赘述,下文主要以新架构带来的功能和开发可能性进行分析。

Turing架构其实并不是完全陌生的,去年NVIDIA发布了TITAN V时就已展示过这项架构,这次NVIDIA换了一种方式用Turing架构来构建游戏产品线。按照NVIDIA以往的显卡展示习惯,每一代旗舰游戏显卡都脱胎于该架构的首款TITAN。

实时光线追踪

新显卡的测评首先带来刷新率和画面效果的提升。新的两款显卡RTX 2080与GTX 1080Ti在实测中,展示了不俗的成绩,在4K画质下都能稳定流畅地运行游戏。且比GTX 1080Ti高出15左右的帧。有同行的小伙伴使用两款显卡对《使命召唤》进行了测试,RTX 2080达到了的93fps,接近破百。

不仅如此,新显卡提供了新的游戏设计方向,且大大提高玩家的游戏真实度——实时光线追踪。

传统的3D渲染一直使用一种叫做光栅化技术。这项技术多年来一直是实时渲染的常规技术,长期使用在游戏中。但是这个技术存在一定的缺陷,如光栅化的阴影经常出现混淆和光泄漏,导致程序员需要去进行BUG修复,且真实感弱。而光线追踪技术长期以来被用于非实时绘制,它通过模拟光的物理行为来提供逼真的光照。

光线追踪通过跟踪光从观看者的眼睛穿过虚拟3D场景时的路径来计算像素的颜色。当它穿越场景时,光可以从一个物体引起反射至其他物体,被物体阻挡会产生阴影,或者穿过透明或半透明物体。所有这些相互作用被组合以产生然后在屏幕上显示的像素的最终颜色。这一种计算工作十分繁重且高负荷的渲染技术,对硬件的要求较高,所以更多的用于制作CG和电影。

新的GeForce 20在Turing架构的每个SM中新增RT Core是迈向实时光线追踪的关键,硬件加速是实现这一目标的唯一途径。将CG电影的技术用于游戏中,获得更流畅、更好的游戏体验,提高沉浸感。

在技术的探讨中,朱亮说出了一句:“4K基本满足游戏竞技对屏幕的要求,分辨率(高分辨率的使用场景)的未来市场在VR上。”

人工智能

在之前的Volta GV100中,英伟达首次引入的张量核心Tensor Core,而此次的Turing架构中的张量核心是前者的增强版本。它设计增加了INT8和INT4精确模式来测算可接受的工作负载,FP16也完全支持这种工作负载的精确测算。

在基于Turing的GeForce游戏核心中引入张量内核,将AI实时深度学习引入游戏应用程序。Turing张量核心加速了NVIDIA NGX神经服务的基于AI的特性,增强了图形、渲染和其他类型的客户端应用程序的效率。对此朱亮举了一个例子:“之前的AI学习例如阿尔法狗,它的学习行为就像司机叫新手上路,但是不同的路况就要有指导,这导致有太多的人工干预。Turing张量核心加速和提高了AI的学习过程及能力,现在老司机只要带他开一次,他就可以自己学习了,这可以大大减轻开发者的开发难度和精力。”

新的NGX神经图形框架将AI集成到整个图形管线中,使AI算法能够执行惊人的图像增强和生成。采用可变速率着色的新图灵着色器架构允许着色器将处理能力集中在细节丰富的区域,从而提高整体性能。例如游戏过程中,AI会着重渲染游玩的画面,对不需要渲染的地方进行适当舍弃。在VR游戏、应用中,游戏的特殊性会出现许多画面渲染上的问题,而人工智能的学习,可以很大程度的减少游戏运行负荷,提高渲染效率。

Virtual Link接口

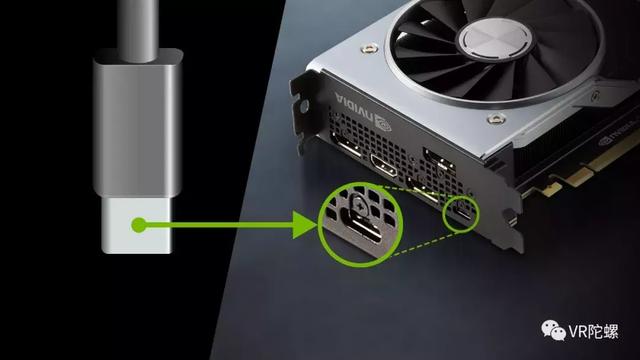

从外观来看,GeForce 20对VR带来的最大的变化就是VirtualLink,现阶段的VR头显与PC的连接需要2-3条线,以HTC为例,需要一个USB接口、一个HDMI接口及另一个充电线。这对终端用户来说会导致线条繁杂的情况,一定情况会限制了玩家在戴着头盔时四处走动的能力。

相信有不少小伙伴尝试过玩到一半,其中一个接口脱落的情况。为了解决这个问题,NVIDIA将其中一个视讯输出端口设计为USB-C并得到SudialLink的硬件支持,叫做VirtualLink。VirtualLink能将VR头盔的供电、显示和回传数据整合到一个USB-C连接上。

Turing 引入的 USB-C 输出可以支持 HBR3 四信道 DP 支持或者 HBR3 双信道 DP+ 双信道 SuperSpeed USB3 支持。而 VirtualLink 则跟更一步,在提供 HBR3 四信道 DP 的同时还支持 SuperSpeed USB 3 用于传输反馈控制信号。USB-C 和 VirtualLink 都能为头盔供电,其中 USB-C 提供了 100 瓦的可选供电支持,而 VirtualLink 则是强制 5 瓦、可选 27瓦。如果头盔的耗电在 27 瓦内,使用一根 VirtualLink 就能满足包括供电、显示、控制反馈,比目前的三根线要简单多了,而它的接口同样是 USB-C。

目前,VirtualLink 获得了 NVIDIA、AMD、微软、Oculus、Valve 的支持。据朱亮透露国内已经有三家头显设计厂商在进行基于VirtualLink接口的头显设计,而HTC目前并没有与英伟达有技术交流。

在接口设计上,陀螺菌咨询了VirtualLink转接外设技术的相关问题(通过转接器将之前的USB线和HDMI线转换成VirtualLink),朱亮表示:“在理论上是可行的。”开发者们对此有没有一些新的想法呢?

1 2 下一页>