神经网络突破:给未来的量子AI铺路

日前,意大利的研究人员通过在一台实际的量子计算机上运行一套特殊的算法,首次研发出起作用量子神经网络。

来自意大利帕维亚大学的Francesco Tacchino领导了一个研究小组,该小组于本月早些时候在ArXiv上传了名为《在实际量子处理器上实现的人工神经元》的预稿。

从根本上讲,他们研发了一种在量子计算机上运行的单层人工神经元网络(artificial neural network,ANN),这种初步的ANN被称为感知器,作为构成更成熟的神经网络的基本部分。

此前在量子系统内创建感知器的相关尝试都涉及将单个量子位当做一个神经网络中的神经元来处理,但这是一个繁琐而错综复杂的过程,很难通过这种方式产生切实有效的结果。

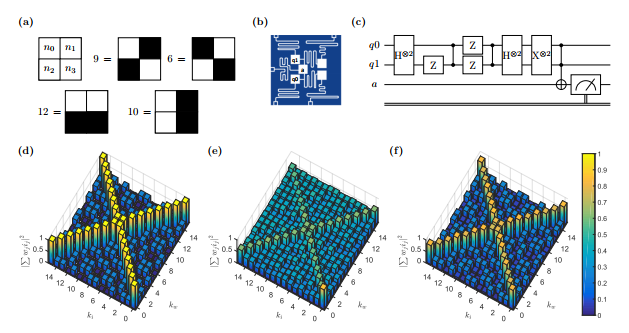

因此,Tacchino和他的团队决定尝试一种不同的方法,他们介绍了一种替代设计来最大限度地模仿量子计算机上的Rosenblatt感知器,并通过实验证实了该方法的有效性——在可用于云量子计算的IBM量子处理器上执行了算法的二量子位版本。

图源自ArXiv官网

IBM Q Experience计算机是一个五量子位并支持云访问的量子系统,长期以来一直被当作一种与量子计算交互的方式,支持使用物理量子计算机和模拟两种模式,为那些没有数百万资金用于实验室建设和访问世界顶级物理学家和工程师的研究人员提供了一个量子计算开源云平台。

量子计算机的最大问题之一就是没有任何适用的软件、程序或代码,对于这台违背物理定律的机器而言,编码是极其困难的,但也不是完全没有可能。

研究小组在IBM Q系统上成功地运行了他们的感知器算法,并使用所得到的神经网络执行图像分类的任务,对此进行了证明。据目前所知,这个小组是第一个尝试使用这种方法的。

现在,这个神经网络能判断给定图像采用了三种基本模式中的哪一种,虽然这听起来似乎微不足道,但足够值得被纳入量子优势的概念体系中。

据研究人员介绍,与经典感知器的模型相比,他们的算法呈现指数级的优势,正如他们只用用二量子位就可以表示和分类四位串,四量子位表示和分类十六位串,以此类推。

这意味着在量子系统上运行的神经网络可能比在经典系统上运行的神经网络在稳健性方面得到指数级地提升,这对未来AI融合量子计算的意义是超乎想象的。

当人们研发出一种机器,而这种机器能充当宇宙的原始基础语言和人类语言之间的翻译者,接下来会发生什么呢?

这或许是给哲学家的最好的提问,但是,在物理学领域,随着研究人员对ANN的深入了解,以及工程师研发出更先进的量子计算系统,一种新的机器学习可能会出现并取代旧的经典深度学习神经网络。

未来的智能机器将不再是由AI或量子单独驱动,而是兼并两者。