由「图片」到「视频」,澎思科技打破视频行人再识别(ReID)技术三项世界纪录

继在三大主流单帧图片行人再识别数据集(Market1501,DukeMTMC-reID,CUHK03)刷新世界纪录后,近日,澎思科技(Pensees)在基于视频的行人再识别数据集(PRID-2011,iLIDS-VID,MARS)中再次取得突破性进展,一举实现在三大数据集上实现算法关键指标首位命中率(Rank-1 Accuracy)大幅度提升,准确率均创历史新高。

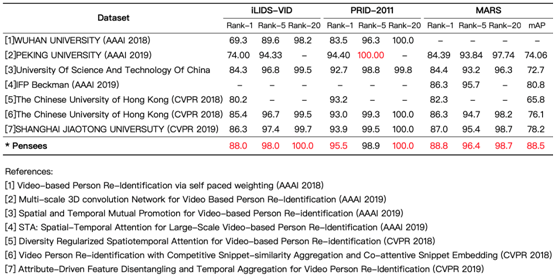

刷新三大数据集世界纪录,实现算法关键指标大幅度提升

PRID-2011、iLIDS-VID和MARS均为基于视频的行人再识别数据集。PRID-2011数据集中的视频对通过两个固定的监控摄像头进行采集,摄像头A包含385个行人,摄像头B包含749个行人。这些行人中,只有200个行人同时出现在两个摄像头中。iLIDS-VID是在PRID-2011之后公布的数据集,与PRID-2011相比,数据更加整齐,也更有挑战性。iLIDS-VID数据集是通过机场到达大厅的CCTV监控视频采集得到的,包含300个行人在两个摄像头下的600段视频。视频中存在严重的着装相似,光照和视角变化,复杂背景和遮挡现象,因此识别难度大。MARS数据集是目前基于视频ReID最大的数据集,是单帧图片行人再识别数据集Market1501的扩充版,图像数量由32,668幅扩展到了1,191,003幅。

与单帧图片的行人再识别数据集一样,首位命中率(Rank-1 Accuracy)和平均精度均值(Mean Average Precision,mAP)是衡量视频行人再识别ReID算法水平的核心指标。澎思科技此次一举实现在三大数据库上,仅利用原始数据就实现Rank-1 Accuracy关键指标大幅度提升。目前,澎思科技算法在最大的视频数据集MARS上的首位命中率指标已经达到88.8%,领先香港中文大学、中科大、北京大学等国内外知名机构。在iLIDS-VID和PRID-2011等数据集上首位命中率也分别达到了88.0%和95.5%。

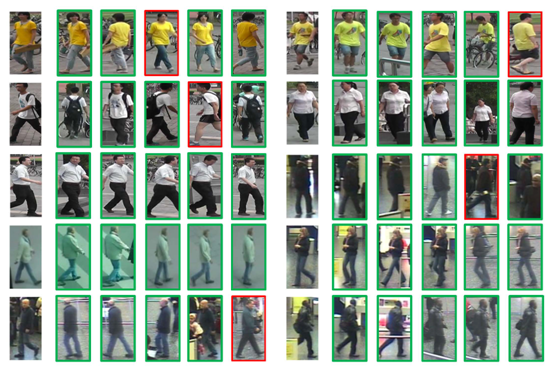

澎思科技行人再识别ReID算法在MARS数据集的部分测试结果

立足澎思现有业务,展开垂直领域技术研发和创新

澎思科技此次成果的取得源于澎思新加坡研究院对算法的自研创新和融合探索,是立足于澎思现有业务和商业模式,结合公司的发展方向针对性开展垂直领域技术研发和创新。主要包括以下几个方面:

1、受遮挡、姿态变化、视角变化等因素的影响,视频序列中行人的特征是不连续的。用全局特征来度量每一帧图片的权重往往会损失掉许多重要的信息。采用分割重组策略将特定局部特征重组成多个视频序列进行学习,进而极大减少局部特征损失对最终特征的影响。

2、其次,提出了全新的双向图注意力机制模块。将图卷积神经网络和SENet完美结合,在整个序列上进行通道域的模式选择学习。同时通过双向网络进行空间域的注意力区域学习。由于图卷积网络的特性,每一帧图片的注意力特征都是与其他帧相互学习结合的结果,从而极大提高特征的代表性。

3、最终,利用帧间相似度进行序列融合。与大多数利用循环神经网络进行融合算法相比,最大的优势是不需要训练额外的模型参数,仅仅通过数学计算的方式就可以达到融合的目的。这样,数据的类内相似度得到了极大的提高。在结合三元损失函数进行训练后,类间相似度得到了降低,进而提高重识别效果。

基于视频的行人再识别与单帧图片的行人再识别任务目的是相同的,即在视角不重叠的多摄像机网络下进行行人的匹配。尽管基于单帧图片的行人再识别算法已经取得了不错的进步,但由于单帧图片只包含有限的行人信息,网络提取的特征不具备足够的代表性,检测结果往往受图片质量的影响较大。

与此相比,视频序列的优势便凸显出来。一个短视频序列往往包含行人多运动状态下的更多特征,并且利用时序信息,可以将背景、遮挡等干扰因素的影响降到最低,提升识别的准确度。

加速AI技术落地,持续推进AI产业化落地进程

基于视频的行人再识别(ReID)技术更贴近智慧城市建设的诸多应用场景,能有效解决行人信息有限、特征不足及其他干扰因素等问题,相比单帧图片的行人再识别具备更长远的落地应用空间。接下来,澎思科技将进一步加大在视频行人再识别算法上的研究,并逐步将算法应用到平安城市、智慧社区、智慧园区、智慧零售、智慧交通等实战应用场景中。

澎思科技作为一家专注于计算机视觉和物联网技术,提供“以人为核心”行业综合应用解决方案的人工智能公司,在人工智能行业进入商业化落地主导的产业化阶段,一方面将不断加强自研技术创新,提升技术竞争力;另一方面坚持“行业+AI”策略,针对用户需求深挖场景,发现行业痛点并不断打磨算法和产品,将技术真正应用到业务场景中,推动AI技术的产品化落地和商业化进程。