突破瓶颈高效测评:谷歌提出自然语言生成任务评测新方法BLEURT

将门创投近年来在自然语言生成(natural language generation, NLG)研究上取得了巨大的进展, 经过充分训练的复杂模型已经可以高精度完成文本迁移、文章总结、参与对话和图片注释等多种任务。目前主要有两种主要方式对NLG系统进行评测:人工测评和自动化度量。

人工测评需要人类标注员在每个模型版本上进行大规模的质量检查,这种方法虽然精度很高但劳动密集型的检查任务十分消耗人力;而像BLEU这样自动化测评方法可以对模型进行迅速的评测,但相较于人类翻译和评审来说经常会出现不可靠的情况。NLG的高速发展和现有测评方法的局限性使得学术界迫切需要开发出新的测评方法来促进NLG系统的发展。

为了解决这一问题,来自谷歌的研究人员提出了一种名为BLEURT的鲁棒文本生成测评指标,BLUERT可以实现非常鲁棒并接近于人类标注的精度水平。

BLEURT (Bilingual Evaluation Understudy with Representations from Transformers) 基于最近高速发展的迁移学习方法进行构建,可以捕捉像句子转述等广泛使用的语言特征。

NLG系统的评测

在人类测评的过程中,系统向人类标注者呈现生成的部分文本内容,让人类基于连贯性和表意来评价内容生成的质量。生成的句子一般与参考句子一对一地进行呈现,参考句子主要来源于网络或者人类作品中。

在机器翻译任务中一个典型的人类测评问题。

人类评测的优点在于其准确性:在评测文本片段时,人类具有无可比拟的准确性。但这种方法对于大规模测评来说,随随便便就需要数十人花费很多天时间,这足以打断高效的模型研发流程。

而自动化测量的主要优势在于低成本、高效率。一般会将待测评结果和参考结果同时输入自动化测评系统,返回描述两个句子间相似程度的分数。典型的方法是使用词汇的重合度来评分,但像BLEU则测算候选句子单词序列同时也出现在参考句子中的次数(非常类似于准确度)。

人类测评与自动化测评的优缺点正好相反,自动化度量十分便捷,可以实时测评训练结果,但他们的精度却无法令人满意。这主要是由于自动化方法聚焦于对生成文本表面相似性的度量,而无法理解人类语言的多样性与精妙。仅靠表面形式来奖励哪些词语上匹配的句子(即使他们没有捕捉到真正的含义)是不公平的测评方法。

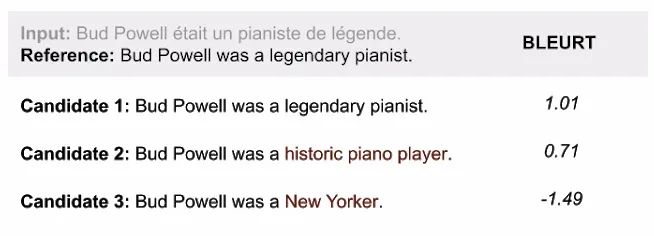

三个备选句子的BLUE分数,第二句显然在语义上接近参考句子,但得分却低于第三句。自动化评测方法仅仅依赖表面的文本信息,而忽略了背后所要传达的意义。

新评测指标BLEURT

BLEURT是一种基于机器学习的自动化度量新方法,可以捕捉句子字面背后的语义相似性。下图显示了BLEURT指标下几个句子的得分情况:

利用BLEURT对三个备选句子进行了测评,虽然2包含两个不同的词,但语义相似性让它获取了高分。

1 2 下一页>