教你使用OpenCV对图像进行特征检测、描述和匹配

磐创AI介绍在本文中,我将讨论使用 OpenCV 进行图像特征检测、描述和特征匹配的各种算法。首先,让我们看看什么是计算机视觉,OpenCV 是一个开源计算机视觉库。当人类看到这张图片时会发生什么?

他将能够识别图像中的面孔。因此,简单来说,计算机视觉就是让计算机能够像人类一样查看和处理视觉数据。计算机视觉涉及分析图像以产生有用的信息。

什么是特征?当你看到芒果图像时,如何识别它是芒果?通过分析颜色、形状和质地,你可以说它是芒果。用于识别图像的线索称为图像的特征。同样,计算机视觉的功能是检测图像中的各种特征。我们将讨论 OpenCV 库中用于检测特征的一些算法。

1. 特征检测算法

1.1 Harris角点检测Harris角点检测算法用于检测输入图像中的角点。该算法有三个主要步骤。确定图像的哪个部分的强度变化很大,因为角落的强度变化很大。它通过在整个图像中移动一个滑动窗口来实现这一点。对于识别的每个窗口,计算一个分值 R。对分数应用阈值并标记角点。这是该算法的 Python 实现。

import cv2

import numpy as np

imput_img = 'det_1.jpg'

ori = cv2.imread(imput_img)

image = cv2.imread(imput_img)

gray = cv2.cvtColor(image,cv2.COLOR_BGR2GRAY)

gray = np.float32(gray)

dst = cv2.cornerHarris(gray,2,3,0.04)

dst = cv2.dilate(dst,None)

image[dst>0.01*dst.max()]=[0,0,255]

cv2.imshow('Original',ori)

cv2.imshow('Harris',image)

if cv2.waitKey(0) & 0xff == 27:

cv2.destroyAllWindows()

这是输出。

1.2 Shi-Tomasi 角点检测器

这是另一种角点检测算法。它的工作原理类似于哈里斯角检测。这里唯一的区别是 R 值的计算。该算法还允许我们找到图像中最好的 n 个角。让我们看看 Python 的实现。import numpy as np

import cv2

from matplotlib import pyplot as plt

img = cv2.imread('det_1.jpg')

ori = cv2.imread('det_1.jpg')

gray = cv2.cvtColor(img,cv2.COLOR_BGR2GRAY)

corners = cv2.goodFeaturesToTrack(gray,20,0.01,10)

corners = np.int0(corners)

for i in corners:

x,y = i.ravel()

cv2.circle(img,(x,y),3,255,-1)

cv2.imshow('Original', ori)

cv2.imshow('Shi-Tomasi', img)

cv2.waitKey(0)

cv2.destroyAllWindows()

这是 Shi-Tomasi 算法的输出。这里检测到前 20 个角。

下一个是尺度不变特征变换。

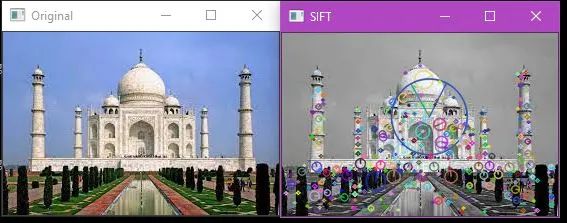

1.3 尺度不变特征变换(SIFT)SIFT

用于检测角、斑点、圆等。它还用于缩放图像。

考虑这三个图像。尽管它们在颜色、旋转和角度上有所不同,但你知道这是芒果的三种不同图像。计算机如何能够识别这一点?在这种情况下,Harris 角点检测和 Shi-Tomasi 角点检测算法都失败了。但 SIFT 算法在这里起着至关重要的作用。它可以从图像中检测特征,而不管其大小和方向。让我们实现这个算法。import numpy as np

import cv2 as cv

ori = cv.imread('det_1.jpg')

img = cv.imread('det_1.jpg')

gray = cv.cvtColor(img,cv.COLOR_BGR2GRAY)

sift = cv.SIFT_create()

kp, des = sift.detectAndCompute(gray,None)

img=cv.drawKeypoints(gray,kp,img,flags=cv.DRAW_MATCHES_FLAGS_DRAW_RICH_KEYPOINTS)

cv.imshow('Original',ori)

cv.imshow('SIFT',image)

if cv.waitKey(0) & 0xff == 27:

cv.destroyAllWindows()

输出如下所示。

你可以看到图像中有一些线条和圆圈。特征的大小和方向分别用圆圈和圆圈内的线表示。我们将看到下一个特征检测算法。

1.4 加速鲁棒特征(SURF)

SURF算法只是SIFT的升级版。以下是代码实现:import numpy as np

import cv2 as cv

ori =cv.imread('/content/det1.jpg')

img = cv.imread('/content/det1.jpg')

surf = cv.xfeatures2d.SURF_create(400)

kp, des = surf.detectAndCompute(img,None)

img2 = cv.drawKeypoints(img,kp,None,(255,0,0),4)

cv.imshow('Original', ori)

cv.imshow('SURF', img2)

接下来,我们将看到如何提取另一个名为 bob 的特征。

2. 斑点检测BLOB

代表二进制大对象。它指的是特定二值图像中具有共同属性的一组连接像素或区域。这些区域是 OpenCV 中的轮廓,具有一些额外的特征,如质心、颜色、面积、均值和覆盖区域中像素值的标准差。以下是代码实现:import cv2

import numpy as np;

ori = cv2.imread('det_1.jpg')

im = cv2.imread("det_1.jpg", cv2.IMREAD_GRAYSCALE)

detector = cv2.SimpleBlobDetector_create()

keypoints = detector.detect(im)

im_with_keypoints = cv2.drawKeypoints(im, keypoints, np.array([]), (0,0,255), cv2.DRAW_MATCHES_FLAGS_DRAW_RICH_KEYPOINTS)

cv2.imshow('Original',ori)

cv2.imshow('BLOB',im_with_keypoints)

if cv2.waitKey(0) & 0xff == 27:

cv2.destroyAllWindows()

让我们看看输出。在这里,斑点被很好地检测到。

现在,让我们进入特征描述符算法。

3. 特征描述符算法

特征通常是图像中的不同点,描述符给出特征,因此它描述了所考虑的关键点。它提取该点周围的局部邻域,从而创建局部图像块并计算来自该局部块的特征。3.1 定向梯度直方图(HoG)在深度学习出现之前,HoG 是对象检测应用中最突出的特征描述符之一。HoG 是一种用于计算图像局部中梯度方向出现的技术。让我们实现这个算法。from skimage.feature import hog

import cv2

ori = cv2.imread('/content/det1.jpg')

img = cv2.imread("/content/det1.jpg")

_, hog_image = hog(img, orientations=8, pixels_per_cell=(16, 16),

cells_per_block=(1, 1), visualize=True, multichannel=True)

cv2.imshow('Original', ori)

cv2.imshow('HoG', hog_image)

下一个是BRIEF。

3.2 二元鲁棒独立基本特征(BRIEF)

Brief 是流行的 SIFT 描述符的替代品,它们计算速度更快,更紧凑。让我们看看它的实现。import numpy as np

import cv2 as cv

ori = cv.imread('/content/det1.jpg')

img = cv.imread('/content/det1.jpg',0)

star = cv.xfeatures2d.StarDetector_create()

brief = cv.xfeatures2d.BriefDescriptorExtractor_create()

kp = star.detect(img,None)

kp, des = brief.compute(img, kp)

print( brief.descriptorSize() )

print( des.shape )

img2 = cv.drawKeypoints(img, kp, None, color=(0, 255, 0), flags=0)

cv.imshow('Original', ori)

cv.imshow('BRIEF', img2)

这是结果。

3.3 定向快速旋转简报 (ORB)

ORB 是一种一次性面部识别算法。它目前正在你的手机和应用程序中使用,例如 Google 照片,你可以在其中对人进行分组,你看到的图像是根据人分组的。这个算法不需要任何主要的计算。它不需要GPU。快速而简短。它适用于关键点匹配。图像中不同区域的关键点匹配,如强度变化。下面是这个算法的实现。import numpy as np

import cv2

ori = cv2.imread('/content/det1.jpg')

img = cv2.imread('/content/det1.jpg', 0)

orb = cv2.ORB_create(nfeatures=200)

kp = orb.detect(img, None)

kp, des = orb.compute(img, kp)

img2 = cv2.drawKeypoints(img, kp, None, color=(0, 255, 0), flags=0)

cv2.imshow('Original', ori)

cv2.imshow('ORB', img2)

这是输出。

现在,让我们看看特征匹配。

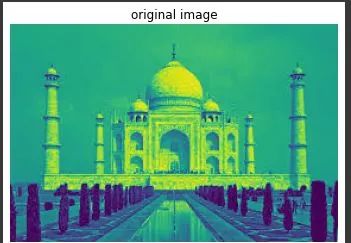

4. 特征匹配

特征匹配就像比较两个图像的特征,这两个图像可能在方向、视角、亮度上不同,甚至大小和颜色也不同。让我们看看它的实现。import cv2

img1 = cv2.imread('/content/det1.jpg', 0)

img2 = cv2.imread('/content/88.jpg', 0)

orb = cv2.ORB_create(nfeatures=500)

kp1, des1 = orb.detectAndCompute(img1, None)

kp2, des2 = orb.detectAndCompute(img2, None)

bf = cv2.BFMatcher(cv2.NORM_HAMMING, crossCheck=True)

matches = bf.match(des1, des2)

matches = sorted(matches, key=lambda x: x.distance)

match_img = cv2.drawMatches(img1, kp1, img2, kp2, matches[:50], None)

cv2.imshow('original image', img1)

cv2.imshow('test image', img2)

cv2.imshow('Matches', match_img)

cv2.waitKey()

这是这个算法的结果。

尾注我希望你喜欢这篇文章。我已经简要介绍了各种特征检测、描述和特征匹配技术。上述技术用于对象检测、对象跟踪和对象分类应用。当你开始练习时,真正的乐趣就开始了。所以,开始练习这些算法,在实际项目中实现它们,看看其中的乐趣。保持学习。