旷视技术开放日,抛出了三个论断

数智前线“在旷视科技的技术开放日(MegTech)上,这家人工智能企业就业界最关注的大模型、算法量产落地和算法定义硬件的最新进展进行了展示与回应。”

技术开放日,是每一家科技公司展现技术价值、回应业界前沿探知的重要时刻。

7月15日,旷视科技的技术开放日(MegTech)如期而至。一群相信技术能改变世界的人聚到一起,将其在AIoT领域的思考和实践和盘托出。

去年旷视科技十周年举办的首届技术开放日,得到的热情反馈,让旷视决定将其固定下来。“我们希望每年都能举办一届MegTech,而且越办越好,让它能够真正成为每位旷视人和旷视朋友的技术节日。”旷视科技联合创始人、CEO印奇说。

旷视联合创始人、CEO印奇

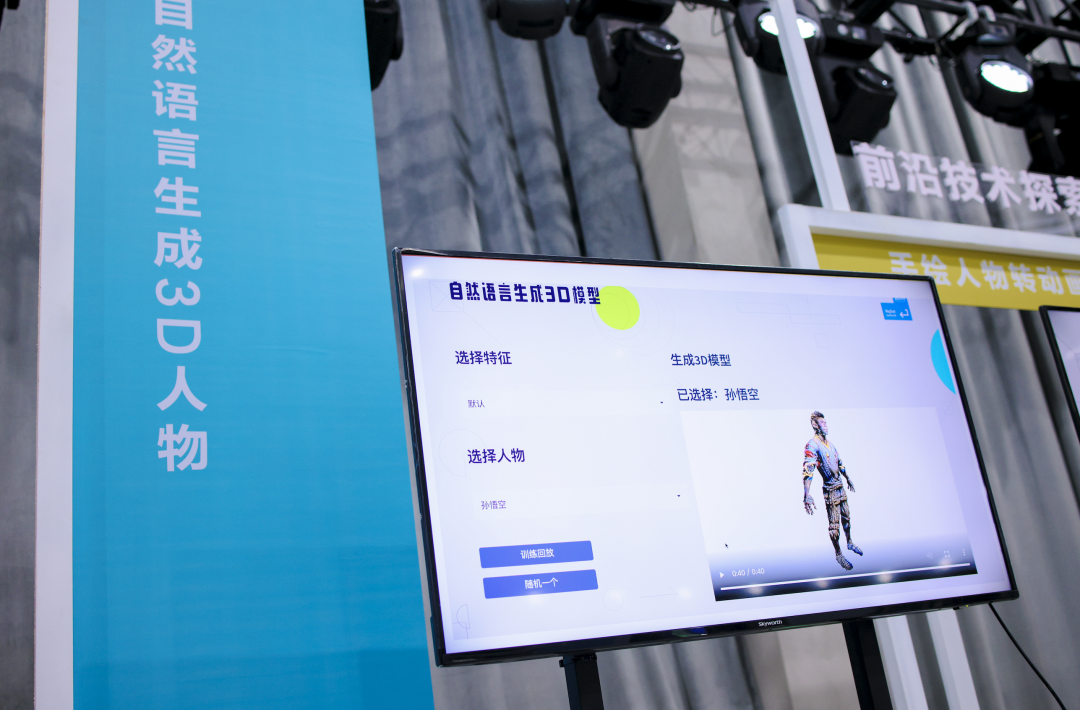

今年技术开放日上展示了20个人工智能的DEMO,其中包括了VR的裸手交互、自然语言直接生成3D人物、瞬时相机等热点科技。不仅如此,对当下人工智能大模型、落地中的一些关键问题,旷视科技的人士也给出了他们的思考和实践。

如今,旷视的技术核心能力都在围绕AI和IoT构建,AI层面包含了两个核心要素:基础算法科研和规模算法量产,IoT的核心要素则是算法定义硬件,而不仅仅是让硬件设备灌入AI算法能力。

‘2+1’的AIoT核心技术科研体系是支撑旷视未来不断走向新的AIoT商业成功的最重要的基石。”印奇说。

01

大模型的“悖论”

过去这些年,热闹的AI领域一直面临着这样一个窘境:听起来很美好,但实际落地很难。

影响落地的一个关键是算法模型的训练。以前是家家户户都在针对不同的业务场景训练AI模型,但因为场景的多样性、复杂性,导致很多人工智能模型要么不经济,要么太单一、泛化性差。

预训练大模型应运而生。它相当于先自动学习大量语言文字和图像数据,形成先验知识。后续的开发者都可以站在巨人的肩膀上,不需要针对每一个场景都建立一套模型。

“大模型的泛化能力强、模型效果更优等特征,助力其成为AI开发新范式,也是现阶段AI市场发展的必然趋势。”IDC中国助理研究总监卢言霞说。

旷视2022年技术开放日DEMO:VR裸手交互

预训练大模型也降低了AI的使用门槛。它可以在不使用大量标记的训练数据,仅仅只给出任务描述,并给出几个从输入到输出示例,便能自动执行任务。

“大模型是提高AI系统性能的最重要的捷径之一。”旷视研究院基础科研负责人张祥雨说,面对复杂的应用场景和多种任务,提高模型性能的最直接途径,就是提高模型本身的表达能力。

而谷歌点燃了大模型的第一把火,随后人工智能研究组织OpenAI将大模型的参数规模推到了1750亿的高度。而到了2021年,大模型的“军备竞赛”演绎得最为激烈。

当年1 月,谷歌推出的Switch Transformer模型参数量已经高达1.6 万亿,打破了Open AI保持的纪录。

国内的巨头也投入到大模型的竞赛中。2021年4月,华为云的超大规模预训练语言模型的参数规模达1000亿;10月,浪潮发布约2500亿的超大规模预训练模型“源1.0”。12月,百度推出的ERNIE 3.0 Titan模型,参数规模达2600亿。而阿里达摩院的M6模型参数达到10万亿,成为全球最大的 AI 预训练模型。

从百亿到千亿,甚至到十万亿规模。这很容易给人一种错觉:参数越大,大模型的效果就越好。

但事实并非如此。“我们发现随着模型的参数量和数据量的增多,我们的收益在逐渐地变少。”张祥雨说。

片面地追求大参数量,不一定能够达到更强大的模型,反而会带来更大的计算开销。像OpenAI的GPT-3大模型,耗资超过1200万美元,非一般企业所能承受。

在技术开放日上,旷视对外表示,他们认为的“大”有三个方面:大模型、大算法和大应用。不仅模型要大,更关键的是如何与算法整合,如何在应用中提高性能。

比如旷视在做大模型上找到一种新方法,传统增大模型的方法主要靠增加深度、宽度,或者增加输入分辨率。旷视提出了一种基于可逆、多column神经网络范式,通过增加可逆column的数量,来扩大化神经网络的参数和计算量。它带来的额外显存消耗非常小,有利于模型的训练和优化。

旷视2022年技术开放日DEMO:自然语言生成3D人物

“‘大’和’统一’是当今视觉AI基础研究的新趋势。”张祥雨判断。除了大,旷视还提到一个基础研究的关键词“统一”。

“这两年我们发现这些算法在底层正在走向统一。”张祥雨说,包括基础模型架构的统一,算法的统一和认知的统一。比如在自动驾驶感知领域,旷视构造了一个新的网络PETR。它的特点就是几乎没有人工设计的成分,而是完全基于相同的架构处理多视角、多时刻、多任务,以及多模态的输入。

底层统一的好处在于,如果各种数据和任务能用统一的算法和模型,就可以构建简单、强大且通用的视觉AI系统。比如,一旦模型统一,AI加速器的设计就会非常简单,一个模型可以适用于各种设备和各种任务。

如今,在“大”和“统一”的指引下,旷视在通用图像大模型、视频理解大模型、计算摄影大模型和自动驾驶感知大模型四个方向上,已经有了不小进展。

02

算法量产的难言之隐

对于AI而言,算法模型还是万里长征的第一步,如何结合具体场景实现量产落地才是最终目标。

早期的算法比较简单,单点突破。但实际的应用场景却非常复杂,单点的算法无法解决实际需求,往往需要把几个算法串在一起,才能完成一个具体需求的落地。

比如在工业园区里的安全生产监测,除了防范火灾,还有人员安全、着装规范、员工操作规范等一系列长尾且碎片化的需求,光让算法识别出是否有火焰,显然是不够的。需要有一个强大的算法生产能力和体系。

这就导致了现在的算法量产越来越复杂。而通常,一个完整的算法生产过程,包含了需求分析、数据处理、模型训练、上线部署,到最后的应用落地。这是一个相当复杂且繁琐的事情。

这个过程存在了三个难点:

一是数据生产的复杂性。

算法是数据喂出来的,数据的质量决定了算法的效果。现实场景的复杂性是一个非常大的挑战。比如检测火焰,火焰的特征非常鲜明,听起来并不难。但现实中很容易把一些高光的物体标注为火焰,例如车尾灯的投影、远处的太阳。而且小火苗和山火也是完全不同的形态,也容易引起歧义。另外,还要剔除大量重复的数据以及破损的图片。这些都是要克服的干扰因素。

二是算法模型的不确定性。

关于算法的模型和文献浩如烟海,选哪个最合适,对于从业者而言是一个非常大的挑战。到底选择何种模型,如何与硬件平台高效匹配,而且在算法落地时,也大概率会遇到漏检、误检的情况。这种技术科研和工程落地之间的巨大鸿沟,是算法领域需要弥合的地方。

三是硬件多样性带来的高成本。

算法需要依赖硬件的算力来实现,AI火热这几年,各种AI板卡非常多,但不同芯片平台往往都有不同的体系结构,导致同样一个功能,还需要先去深入了解芯片平台的结构,才能写出高效的代码,增加了AI生产人员的部署成本。

看起来,每一个问题都很棘手。

但旷视在技术开放日上对外表达了他们解决算法生产难题的根本:标准化。AI算法只有标准化才能实现自动化,才能普惠易用。这里包括数据生产的标准化、算法模型的标准化和整个推理框架的标准化。

标准化听起来非常简单,但每一步都要考虑到位,一个细小的差别,最终都可能给最终结果带来偏差。就像开车一样,有些国家靠左,有些国家靠右,有些国家限速,有些国家不限速,红绿灯的设置和表达又有不同。如果规则都统一,底层架构也统一,这些困扰就能迎刃而解。

为此,旷视搭建了统一的算法生产平台AIS(AI Service)。它基于旷视的Brain++体系,提供了从数据清洗、智能标注、数据管理、数据质检、算法自动生产、模型多维能力评测、pipeline部署等全流程能力。

旷视2022年技术开放日DEMO:AIS算法生产平台

“标准化是我们在算法生产流程中的核心优势,这也是算法生产平台AIS为大家提供的能力。”旷视研究院算法量产负责人周而进说。目前,AIS平台已经能够支持100多种业务模型训练,最快2小时即可完成,而且模型产出精度指标远高于业界平均水平。经验证,算法研发人员使用Brain++和AIS平台,可以实现智能标注平均加速30倍,自动学习训练加速4至20倍。

其实,旷视在2020年发布Brain++时,就将其中最核心组件深度学习框架天元(MegEngine)开源,让更多企业与开发者实现更简单的开发。

“我们希望去降低算法生产的门槛,从而鼓励更多的行业技术人员参与到算法生产的过程中,打通各行各业的Know-how,一起去建设一个开放的算法生产生态。”周而进说。

03

算法如何定义硬件

硬件在AI落地上扮演着非常重要的角色。

“在每个AI真正能够规模化落地的场景里面,我们需要找到一个特别的硬件载体,一个非常好的IoT设备。在这样的载体当中,才可以真正让AI发挥巨大作用。”印奇说。

也正是基于此判断,旷视在硬件道路上的探索比较坚持。作为AI算法起家的公司,旷视没有硬件工程的天然基因。其实,不仅是旷视科技,像百度这些主打AI的公司,都在强调软硬一体的战略,加强对硬件的重视。行业普遍意识到,AI算法不是空中楼阁,需要生长在硬件设备上。

所以,我们也看到,像海康威视、大华这些传统的硬件厂商已提出AIoT的战略。对于这些企业而言,他们有着足够大的硬件出货量,给AI提供了天然的应用场景。

但是,以前都是先有硬件,然后将AI算法的能力导入。这一点有点类似于早年的电动车,基本是燃油车改装,把油箱和发动机换成了电池和电机,无论是驾驶体验还是整体性能,与现在的电动车相差甚远。

现在,AI算法反过来在影响硬件的形态和生态。

“算法对传感器到底需要提供什么样的信息和输入,提出了要求,甚至本质性地改造了传感器的形态和样式。”旷视研究院计算摄影负责人范浩强说,旷视在今年提出了“算法定义硬件”的理念,AI传感器是这个理念的核心单元。

比如,以前要拍出一张高清照片,不仅需要专业设备,还得选个好天气。现在智能手机的发展让夜间拍照也变得非常清晰自然。而背后其实就有AI算法的功劳,也就是说每一次按下快门,其实都是经过了大量的运算。

旷视2022年技术开放日DEMO:探囊取物

但要实现AI的能力,需要根据算法对镜头的防抖、对焦以及光线传感等组件进行定制,才能实现影像能力的提升。这就是AI对硬件的反向输出。

再比如,大家每天使用的手机指纹识别,以前用的是电容屏,其原理是让指纹形成不同的电容值。而这几年为了追求更高的屏占比,开始用屏下光学指纹,相当于给指纹拍个照,难度明显更大。

但AI算法在快速推动屏幕指纹技术的演进。以前的屏幕指纹,需要一个非常完整的图像,而最新的AI指纹识别技术,甚至只需要两根脊线就可以完成对身份的确认。“这就是当我们打通了传感器、算法以及整个成像技术之后,能够给大家带来的奇迹。”范浩强说。

而从应用到算法到传感器的全链路整合能力,被认为是旷视算法定义硬件的核心。

旷视是业界极少数能将传感器的光学、模组、电子学的设计能力,传感器的物理建模和算法能力,以及传感器的应用能力融为一体的公司。“旷视非常有幸能够成为其中一员,这也是我们进一步参与AI定义传感器这件事情的最大信心和底气。”范浩强说。

而通过技术开放日,我们看到了一个AI公司相对完整的演进路径:既要有基础科研保证技术和算法模型的先进性,也要能让算法量产变成产品,反向定义硬件,最终让人工智能发挥出它的商业和社会价值。