大暴走!英伟达官宣全球最强AI芯片,性能提升超30倍

数智研究社

文|陆知春

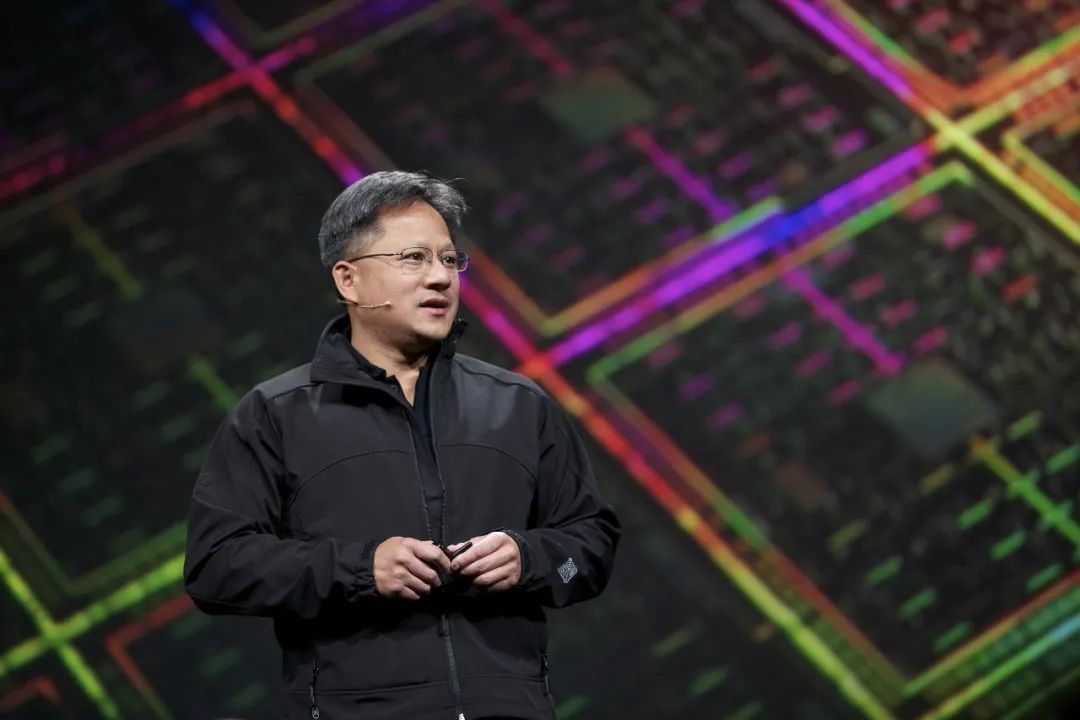

北京时间3月19日凌晨4:00,在美国加州圣何塞会议中心举办的GTC 2024大会正在进行中。在舞台中央,“皮衣刀客”黄仁勋又推出了继H100、A100之后的又一核弹级芯片产品。

过去的2023年,英伟达的业绩取得了巨大成就。因而,2024年的GTC大会备受市场关注。

在GTC大会召开之前,诸多外媒就开始小道消息频传:黄仁勋将在GTC大会上发布一款新的GPU产品。果然,黄仁勋不负众望,采用Blackwell架构的B200和GB200系列芯片“千呼万唤始出来”。英伟达表示,采用Blackwell架构的系列芯片将是迄今为止最强大的AI芯片产品。

黄仁勋称,B200芯片拥有2800亿个晶体管(作为对比,H100/H200上有800亿个晶体管),采用台积电4NP工艺制程,可以支持多达10万亿个参数的AI模型。

有意思的是,B200芯片并不是传统意义上的单一GPU,是由两个紧密耦合的芯片组成,这两个芯片通过10TB/s NV-HBI(NVIDIA高宽带接口)连接进行连接,以确保它们能够作为单个完全一致的芯片正常运行。

「数智研究社」获悉,B200系列的Blackwell架构在AI安全方面又向前迈进了一步。而且,Blackwelll将被整合到英伟达的GB200超级芯片中,这个超级芯片可以将两个B200GPU连接到另一个GPU中去。

但截至目前,英伟达没有透露价格。新品上市的时间,也没有给出具体上市的时间。但如AWS、谷歌、微软等知名公司都已经发出了使用Blackwell GPU的信心和欲望。

在演讲中,黄仁勋坦言,“生成式人工智能是我们这个时代的决定性技术。Blackwell架构的GPU是推动这场新工业革命的引擎。英伟达和世界上最具活力的公司合作,将实现人工智能对每个行业的承诺。”

除了发布新架构的GPU产品外,英伟达还发布了GB200 NVL72液冷机架系统,包含36颗GB200 Grace Blackwell超级芯片,拥有1.4 exaflops的推理能力,内部含5000根单独的电缆,总长度接近两英里。

英伟达在发布会上着重介绍了这一产品,和用于推理的相同数量的H100 Tensor Core图形处理单元相比,GB200 NVL72的性能提升高达30倍,同时成本和能耗降低25倍。

有举例为证,此前训练一个1.8万亿参数模型需要8000个Hopper GPU和15兆瓦的功率。如今,只需要2000个Blackwell GPU和4兆瓦的功率就能完成训练。

此外,英伟达表示还将推出一款服务器主板,名为HGX B200。此主板支持在单个服务器节点中使用8个B200 GPU和一个X86架构的CPU。

除了硬件的“暴走式”升级外,在软件方面,英伟达也展示了自身在未来发展中的AI战略。黄仁勋在现场推销起了AI软件订阅服务包,推出了NVIDIA推理微服务等。

黄仁勋在现场表示,英伟达正在认真考虑从本质上重新设计整个底层软件堆栈,希望AI能助英伟达一臂之力。但从资本市场来看,英伟达当日高开5%,但收盘时涨幅不到1%。盘后股价则走跌超1%。

本文由数智研究社原创出品,未经许可,任何渠道、平台请勿转载。违者必究。