人工智能之人工神经网络(ANN)

AI优化生活通过上一篇文章《人工智能之深度学习》,我们清楚地知道深度学习(DL)的概念源于人工神经网络ANN(Artificial Neural Network)。人工神经网络ANN是20世纪80 年代以来人工智能领域兴起的研究热点。人工神经网络ANN简称为神经网络或类神经网络。深度学习实际上是深度神经网络DNN,即深度学习从人工神经网络ANN模型发展起来的,因此有必要对人工神经网络ANN作进一步探讨。^_^

最近十几年来,人工神经网络ANN的研究工作不断深入,已经取得了很大进展,其在模式识别、智能机器人、自动控制、预测估计、生物、医学、经济等领域已成功地解决了许多现代计算机难以解决的实际问题,表现出了良好的智能特性。

那么究竟什么是人工神经网络ANN呢?

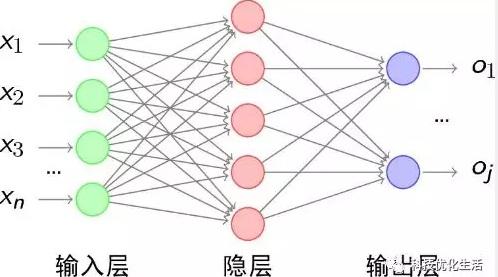

人工神经网络ANN从信息处理角度对人脑神经元网络进行抽象,建立某种简单模型,按不同的连接方式组成不同的网络。人工神经网络ANN是一种运算模型,由大量的节点(或称神经元)之间相互联接构成。每个节点(神经元)代表一种特定的输出函数,称为激励函数(activation function)。每两个节点间的连接都代表一个对于通过该连接信号的加权值,称之为权重,这相当于人工神经网络的记忆。网络的输出则依网络的连接方式,权重值和激励函数的不同而不同。而网络自身通常都是对自然界某种算法或者函数的逼近,也可能是对一种逻辑策略的表达。

人工神经网络ANN的发展历程:

1) 人工神经网络ANN的概念由W.S.McCulloch和W.Pitts等人于1943年提出。他们通过MP模型提出了神经元的形式化数学描述和网络结构方法。

2) 1960s年,人工神经网络得到了进一步发展,更完善的神经网络模型被提出,其中包括感知器和自适应线性元件等。1982年, J.J.Hopfield提出了Hopfield神经网格模型,引入“计算能量”概念,给出了网络稳定性判断。 1984年,他又提出了连续时间Hopfield神经网络模型,开创了神经网络用于联想记忆和优化计算的新途径。这项开拓性的研究工作有力地推动了神经网络的研究。

3) 1985年,有学者提出了波耳兹曼模型,在学习中采用统计热力学模拟退火技术,保证整个系统趋于全局稳定点。

4) 1986年进行认知微观结构地研究,提出了并行分布处理的理论。

5) 1986年,Rumelhart, Hinton, Williams发展了BP算法。迄今,BP算法已被用于解决大量实际问题。

6) 1988年,Linsker对感知机网络提出了新的自组织理论,并在Shanon信息论的基础上形成了最大互信息理论,从而点燃了基于NN的信息应用理论的光芒。

7) 1988年,Broomhead和Lowe用径向基函数(Radial basis function, RBF)提出分层网络的设计方法,从而将NN的设计与数值分析和线性适应滤波相挂钩。

8) 90年代初,Vapnik等提出了支持向量机(Support vector machines, SVM)和VC(Vapnik-Chervonenkis)维数的概念。

9) 美国国会通过决议将1990年1月5日开始的十年定为“脑的十年”,国际研究组织号召它的成员国将“脑的十年”变为全球行为。在日本的“真实世界计算(RWC)”项目中,人工智能的研究成了一个重要的组成部分。人工神经网络的研究从此受到了各个发达国家的重视。

人工神经网络特征:

人工神经网络是由大量处理单元互联组成的非线性、自适应信息处理系统。它是在现代神经科学研究成果的基础上提出的,试图通过模拟大脑神经网络处理、记忆信息的方式进行信息处理。人工神经网络具有四个基本特征:

(1)非线性:人工神经元处于激活或抑制二种不同的状态,这种行为在数学上表现为一种非线性关系。具有阈值的神经元构成的网络具有更好的性能,可以提高容错性和存储容量。

(2)非局限性:一个神经网络通常由多个神经元广泛连接而成。一个系统的整体行为不仅取决于单个神经元的特征,而且可能主要由单元之间的相互作用、相互连接所决定。通过单元之间的大量连接模拟大脑的非局限性。

(3)非常定性:人工神经网络具有自适应、自组织、自学习能力。神经网络不但处理的信息可以有各种变化,而且在处理信息的同时,非线性动力系统本身也在不断变化。采用迭代过程描写动力系统的演化过程。

(4)非凸性:一个系统的演化方向,在一定条件下将取决于某个特定的状态函数。非凸性是指这种函数有多个极值,故系统具有多个较稳定的平衡态,这将导致系统演化的多样性。

1 2 下一页>