相机的时代:Google Lens一年蜕变录

AI锐见人工智能时代,没有人会觉得相机的功能只是单纯的拍照。

随着智能手机的普及,存储变得更加便宜和便利,我们可以随时拍摄各种类型的照片,从日出到日落,从他拍到自拍。旅行、学习、工作,相机渗透到我们生活的方方面面。

据估计,我们的大脑皮层中有30%的神经元是用于视觉的。每一个清醒的时刻,我们都依靠我们的视觉来感知我们周围的环境,记住各种各样的信息,并探索我们周围的世界。

我们使用相机的方式并不是唯一改变的事情,相机背后的技术也在不断发展。

随着硬件、软件和人工智能的不断发展,相机将远远超越摄影,它将帮助我们搜索所看到的事物,提供更多的信息。

Google Lens就是在这样的背景下诞生的。

Google Lens是谷歌在2017年推出的一项技术,简单来说就是利用手机上的摄像头,能够扫描产品、动物、文本或者其它存在于环境当中的事物,并成功将其识别出来。

这项服务依赖于由谷歌及其它来源提供的信息,借此为用户提供与目标相关的准确资料。

谷歌在一篇新的博客文章中写道,Google Lens现在可以识别超过10亿件物品。

当然,这10亿件商品来自Google购物中提供的产品,因此,那些模糊不清的东西就不会包含在内了,例如我们小时候玩的游戏机或某个稀有书籍的第一版。

除了购物项目之外,谷歌镜头现在还可以识别人员、Wi-Fi网络名称和几何形状。

这也算谷歌镜头一项重大的进步了。

一、Google Lens:搜索你看到了什么

当我们看到一只可爱的秋田犬,想知道它的品种是什么?我们会怎么向别人形容它呢?黄色的、毛茸茸、爱笑,这应该算是很多品种的狗狗共有特征。

但是,如果你用谷歌镜头对准狗狗,那么,关于狗狗的品种和其它信息就会立马呈现在你的手机上。

也就是说,Google Lens把你看到的内容转换为搜索查询。

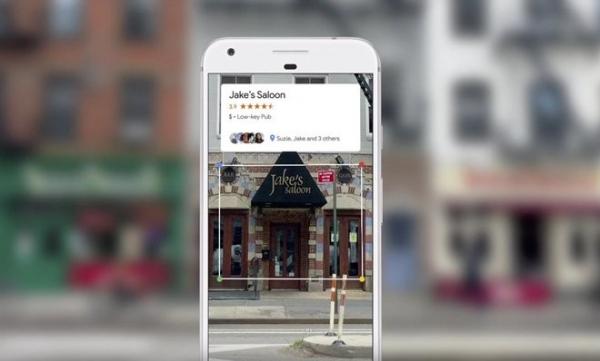

除了搜索你看到的物体,Google Lens还可以找到你的兴趣点,比如,当我们把镜头对准一个建筑物,就会自动显示相关的信息和网上评论,或者,我们把镜头对准一个音乐专辑,谷歌镜头会自动识别其标题并为你提供源自网络的评论内容。

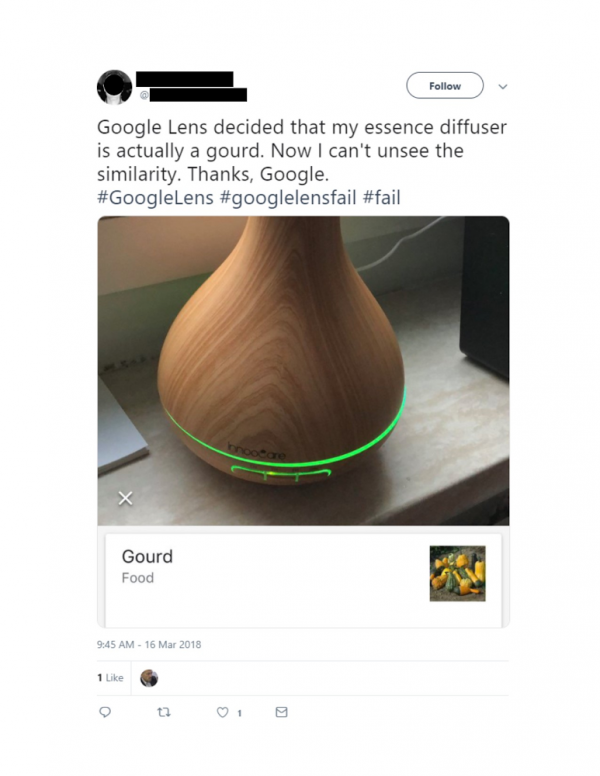

当然,谷歌识别也不是每次都是正确的,一些特性不是那么明显的物体,它就很有可能识别错误。

Google Lens是在去年谷歌I/O开发者大会推出的,主要运用机器学习和计算机视觉技术,当时,Google Lens还仅面向谷歌公司的Pixel系列手机产品,且首先登陆Pixel 2设备之上(随后也可在初代Pixels上运行)。

现在,Google Lens可以在其他安卓手机上运行,也可在苹果IOS系统运行。

二、Google Lens:读懂现实世界

在今年的I/O开发者大会上,谷歌针对Google Lens进行了三项更新。

1、智能文本选择功能

这个功能可以将我们看到的单词与需要的答案和操作连接起来。Google Lens可以阅读现实世界的文本信息,并且可以复制并粘贴这些文本到手机上,比如食谱或Wi-Fi密码。

为了教导镜头阅读,谷歌开发了一个光学字符识别(OCR)引擎,并将其与我们对搜索语言和知识图的理解相结合。谷歌使用不同的字符、语言和字体训练机器学习算法,并使用Google Books扫描等资源。

有时候,Google Lens很难区分字母“o”和“0”之类的相似字符。对此,Google Lens使用谷歌搜索中的语言和拼写校正模型来更好地理解角色或单词的可能性。比如,看到“c00kie”,Google Lens可以猜测单词的意思是“饼干”。

2、风格搜索

当一件衣服或家居装饰吸引了我们的眼球,我们可以打开镜头,不仅可以得到关于那件特定物品的信息,而且还可以看到与你喜欢的款式相似的东西。

3、实时搜索

Google Lens现在能够主动地即时呈现信息,它将其锁定在您用户看到的事物上。用户只需对准相机,Google Lens可以在瞬间识别出数十亿个单词、短语、位置和事物,用户就可以更好地浏览周围的世界。

结语:

当我们走在国外陌生的街道上,只需把手机镜头对准不认识的字,相机就可以自动翻译;当我们站在某个建筑物面前,打开相机,就可以了解关于这个建筑物的一切信息。

我们现在正处在一个相机的时代,人工智能和机器学习的快速发展,可以使相机成为我们周围世界的强大而直观的界面。