人性:下一个AI的里程碑

张康康

3月18日,斯坦福以人为本 AI 研究院(Stanford HAI)成立了。斯坦福利用 HAI 评估智能机器对人类生活所造成的影响,包括机器自动化取代了部分人力工作,算法引起的性别和种族偏见,医疗、教育和司法系统中存在的 AI 问题。在研究院的发布会上,联合主任李飞飞强调了 HAI 需要秉持“以人为本”的初衷,提出了三点:

1)发展 AI 的过程中必须考虑 AI 对人类社会的影响;

2)AI 的应用是为了赋能人类,而非取代人类;

3)人工智能应该更多融入人类智慧的多样性、差异性和深度。

技术飞速发展,人工智能对教育、科技、卫生和可持续发展等方面都起了关键性助力作用。但同时,人工智能也给人类提出了一系列复杂的挑战。关于上述三个原则,李飞飞希望:智能机器更加以人为本,怀有善意。

什么是“以人为本”?

根据李飞飞提到的三点原则进行解读。第一点,作为技术的发明者,人类应该正确的引导AI的发展,更好地服务人类。比如在数据安全、隐私保护、社会伦理、知识产权等各个问题上,由世界性的权威组织制定严格的标准和法规,减少AI带来的潜在的威胁,这已经基本达成共识。

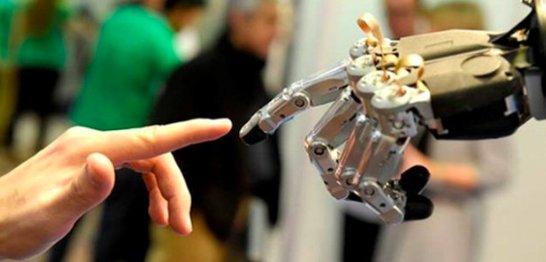

关于第二点,自人工智能诞生以来,“人类会不会被AI取代”、“AI会不会毁灭世界”等耸人听闻的问题时常被提起。作为一项技术,AI应当是中性的,技术是用来服务人类的。从大的方向来看,AI不断进化它的判断和感知技能,在比较简单、重复性、危险性的工作上帮助人类,而人类的能力可以更加专注于更高层次的人物,偏向创造性和感性的部分,最终更有意义。

最后,近年来,AI发展出了计算机视觉、语音识别等能力,但在实际生活中,AI远远落后于神经元、人类智能的丰富和灵活性。例如,阿尔法狗击败了世界冠军,但它无法从胜利中感受到喜悦,也不会在胜利后产生拥抱心所爱之人的渴望。例如,AI可以在一张照片中得知图片中的内容是什么,但是不能轻易识别图片背后的故事的因果关系。人工智能需要变得更有情感意识,加强对情感和情绪的认知,不仅能够捕捉对人的情感,更需要让机器跟人进行情感的表达。

人性化AI无处不在

我国的人工智能正处在快速发展的时期,技术攻关和产业应用近几年来发展势头迅猛,目前已经被广泛应用于语音识别、计算机视觉、机器人、语言处理等领域,代表性产品包括旷视科技的“FaceID在线人脸身份验证”、极链科技的“VideoAI视频应用系统”、优必选的“个人智能机器人悟空”等。随着AI更加深度、多样性,具有情感的细腻,将在产业应用中带来更多维度的发展。

例如,使用情感AI帮助人们利用强大的技术建立与其他人的联系在医疗行业已经逐步应用。在自闭症这一医学难症中,AI技术能够实现与自闭症儿童进行反馈,集成反馈的数据,为定制治疗方案提供支撑。利用AI机器可以促进自闭症儿童和日常接触人之间的沟通,教会自闭症的人读懂他人细微的情绪;另外,还能够帮助身边的人更好的识别自闭症儿童情绪。

AI在听说读写、推理等方面的能力、效率和准确度持续提升,也可以为视觉、听觉、感知、学习、行动能力有所不便的人群,打造出人工智能应用和产品。例如,利用微软的人工智能技术和认知服务中的Microsoft Translator 服务,实现自动语音识别解决方案,可以帮助听力受损人群无障碍沟通。AI技术有希望帮助世界各地超过10亿残障人士,打造一个完整、平等、便利的世界。

类似的应用在教育场景下,AI也能发挥无限量的作用。AI可以通过学生的面部表情和姿势对情绪作出有根据的判断,衡量每个学生的理解程序,可以帮助老师因材施教。

人类准备好了吗?

随着人类越来越依赖于机器智能,我们的责任观念将会变成什么样?人工智能的生成物是否为作品,是否有著作权的问题?自动驾驶的安全性、责任认定等法律问题不断涌现,人工智能干预的事故应当如何定责?甚至是否赋予机器人以虚拟的“法律主体资格”?还有很多重要的应用领域,如安防,如果系统出现原则性决策失误,如何判定?如何让人工智能可解释、可说明?

智能机器触发的人们对隐私、安全的担忧,该如何规避?AI的大幅度应用对就业的影响该如何权衡?在人工智能不断走进生活的过程中,人类真的准备好了吗?

这需要政策制定者、法律学者、伦理学家、科学家,大家一起寻找答案。但现状很显然,人工智能安全健康发展法规和伦理道德研究尚且不足,相应的法律法规以及道德规范要求还不健全,我们还不能有效防范控制潜在的安全风险。科学向善,AI以人为本,我们需要考虑的事情还很多。

小结:

与所有颠覆性技术一样,新一代人工智能具有高度的不确定性,可能有很长的一段时间是不完美的,需要政府、社会、企业共同努力,规范人工智能的发展。但有一点是很肯定的,技术的产生,是为了让人类生活的更好,我们要帮助AI更加人性化,拥有更好的未来。