如何重塑智能化世界的信任、隐私和道德边界?

算力智库当各个行业部署人工智能技术时,首先需要处理一些技术、伦理、可靠性和法规相关的挑战。例如,在交通和汽车领域实施人工智能时,安全和保障是主要挑战之一。本期文章将探讨人工智能在道德伦理方面需克服的难题,目前,除了解决相关技术、算法问题,政府和监管机构也需预见关键的伦理和社会挑战,并开始制定新政策予以应对。

本文编译自国际电工委员会(IEC)于2019年3月发布的报告《人工智能将赋能哪些行业》,报告描述了人工智能当前使用的主要系统、技术和算法,并指出了它们有助于解决哪些类型的问题以及面临的主要挑战。本文节选自第六章:人工智能的挑战。

国际电工委员会(International Electrotechnical Commission)是世界上成立最早的国际性电工标准化机构,目前IEC的工作领域已由单纯研究电气设备等问题扩展到通讯、视听、机器人、信息技术、新型医疗器械和仪表等各个方面。

【算力观点】

机器学习的自动化决策依赖于合作伙伴间的信赖和数据质量的保障。糟糕的数据质量、甚至恶意的操作,都可能导致毫无价值的结果,甚至对算法的用户产生负面影响。

人工智能的一大伦理挑战是,当面临道德困境时如何进行决策。一个可以被广泛接受的伦理框架需要人类进一步研究,以便对人工智能系统在推理和决策时进行指导。

人工智能的数据共享系统引发信任挑战

人们普遍认为,人工智能是一个涉及许多不同利益相关者的主题。例如,在制造业的预测维修领域,为了给人工智能算法提供足够的支持,制造商和用户都必须共享数据,提供专业知识。为了促进这种合作,需要处理一些问题,例如可信度问题。

利益相关者之间的信任至关重要,解决数据源可靠性问题的方案将可能由认证技术提供。利用有公信力且数据密封的机构所颁发的信用电子证书,是在各方之间建立信任的一个选项。

然而,这个解决方案的目标仅仅是在合作伙伴之间建立信任,并没有解决数据质量问题。为此目的,可以收集可信的数据池或评估算法来避免错误的数据库。然后,元算法可以帮助人工智能系统在一段时间内保持可靠和透明,提供关于源数据的起源和分布信息。

统一协调的人工智能监管机构尚未诞生

许多人工智能领域仍然缺乏适当的监管。为人工智能发展找到一种平衡的监管方法,同时保证消费者保护、社会保障以及权利和自由的保护,是世界各地许多政府的一项重要优先事项。虽然在无人驾驶汽车和无人机等领域已经采取了一些早期立法措施,但世界上还没有专门针对人工智能的监管机构,而且也缺乏对人工智能的法律研究。

百度无人驾驶汽车

例如,在欧洲,机器人和人工智能方面由国家和各级不同监管机构负责,没有任何中心机构为这些领域的发展提供技术、伦理和管理方面的专门知识和监督。这种缺乏协调的情况,不利于对技术发展所带来的机会和挑战作出及时和充分的反应。

如何令人工智能受到人类道德的约束和保护?

尽管关于伦理问题的严重影响将出现在未来更先进的人工智能系统中,但主动尽早解决这些问题不仅是一种谨慎的做法,而且还可能避免未来昂贵的改造成本。

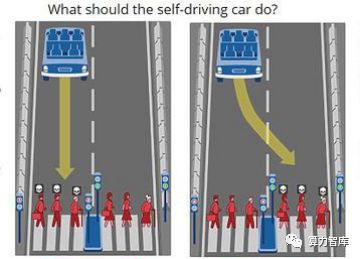

更直接的担忧是人工智能系统(如自动驾驶汽车)在决策过程中需要作出道德选择,例如,假设在无人驾驶汽车无法及时刹车且前方人行道上有三个行人时,系统应该选择撞向这三个行人,还是转向道路另一边的行人?

这个例子说明了人工智能安全不仅是一个技术问题,而且是一个政策和伦理问题,需要跨学科的方法来保护这些技术的用户、中立的旁观者和开发这些技术的公司(后者可能面临重要的法律挑战)。虽然研究组织和公司已开始处理这些问题,但需要在国际层面上加强各方之间的合作。

自动驾驶的道德困境

图片来源:MIT Technology Review

存在于人类日常生活中的人工智能应用处于伦理挑战的核心,如果人工智能系统的设计不符合伦理和社会约束,这些系统可能会按照与人类不同的逻辑运行,并可能导致巨大后果。

此外,在赋予机器决策权之后,人们将面临一个新的伦理问题:机器是否有资格做出这样的决策?随着智能系统获取特定领域的知识,其决策能力将可能超过人类,这意味着人们会在越来越多的领域依赖于机器主导的决策。在未来的人工智能发展中,这类伦理挑战将迫切需要特别关注。