AI伦理背后的权力游戏

猎云网在最近于梵蒂冈城举行的“数字时代科技公益大会”上,教皇敦促Facebook高管、风险投资人和政府监管机构警惕人工智能和其他技术的影响。他说:“如果人类所谓的技术进步成为共同利益的敌人,这将导致一种不幸的回归,人类将回到一种由最强者法则支配的野蛮状态。”

今年夏天,Joy Buolamwini与民主党众议员Alexandria Ocasio-Cortez一起在国会作证,多次审计发现面部识别技术对白人男性效果最好,对有色人种女性效果最差。

这两个事件的共同点是它们都讨论了AI伦理中的权力动态的关系。

关于人工智能伦理的争论可以在不提及“权力”一词的情况下展开,但“权力”往往隐藏在议题之下。事实上,它很少是直接的焦点,但它必须是。人工智能中的权力就像地心引力一样,有一种无形的力量,它影响着人工智能中所有对伦理的思考。

权力影响了那些用例相关的方法、需要优先考虑的问题,以及工具、产品和服务的服务对象。

它是关于公司和国家如何制定政策管理技术使用的辩论的基础。

它存在于有关民主化、公平和负责任的人工智能的对话中——谷歌CEO桑达尔·皮查伊将人工智能研究人员请进了他的办公室;顶级机器学习实践者被视为现代哲学家之王;埃隆·马斯克等人讲述着人工智能技术可能在未来几十年对人类造成的恐怖影响……

消费者或许会觉得数据保护毫无希望,或者工程师知道某些事情在道德上有问题,但却找不到追索权。

一般来说,初创公司可能会把道德标准当作一个不错的附加条件,但不是必须具备的。想要第一个进入市场,并在最后期限前完成产品发布的工程师可能会嘲笑把宝贵的时间放在考虑道德规范上的想法。首席执行官和政客们可能只会嘴上说道德,但最终只会发出同情的信号,或进行道德清洗。

人工智能被称为21世纪最大的人权挑战之一。这不仅仅是做正确的事情或尽可能制造最好的人工智能系统,这是关于谁掌握权力以及人工智能如何影响它所涉及的一切力量的平衡。

这些权力动态将定义商业、社会、政府、世界各地个人的生活、隐私的未来,甚至我们未来的权利。几乎每个人工智能产品经理都喜欢说,事情才刚刚开始,但在人工智能时代,如果不能解决不平衡的权力动态,可能会产生危险的后果。

劳动力市场和新镀金时代

深度学习、云计算、像GPU这样的处理器,以及更快地训练神经网络所需的计算能力——这些技术已经成为大型科技公司的基石——推动了今天的复兴。

第四次工业革命与历史性的收入不平等和新镀金时代同时到来。就像19世纪铁路大亨利用农民急于将作物推向市场的心态一样,拥有专有数据集的科技公司利用人工智能进一步巩固自己的市场地位和垄断地位。

当数据比石油更有价值时,拥有有价值数据的公司则具有巨大优势,最有可能巩固财富或行业领导者的地位。这当然适用于像苹果、Facebook、谷歌、IBM和微软这样的大牌公司,但也适用于传统企业。

与此同时,科技巨头并购速度加快,并进一步巩固实力,进而巩固了其他趋势,因为研发几乎完全属于大型企业。

根据斯坦福大学人类中心人工智能研究所(HAI)最近的一份报告,人工智能的不断增长可能会导致社会的巨大失衡。

“人工智能的潜在金融优势非常大,和AI贫富之间的鸿沟太深了,就我们所知,全球经济平衡可以通过一系列灾难性的构造发生变化,”HAI的一个提案呼吁美国政府在未来10年投资1200亿美元在教育、研究和创业领域。

该提案的共同作者是前谷歌云首席人工智能科学家李飞飞博士。她说:“如果指导得当,人工智能时代可能会为所有人带来一个繁荣的时代。”

普华永道估计,到2030年,人工智能将为全球经济贡献15.7万亿美元。然而,如果我们不负责任地利用它,将导致财富和权力更集中在少数迎接这个新时代的精英人士身上,而全球大多数人将陷入贫困,丧失使命感。”

麻省理工学院(MIT)数字经济项目(Initiative on the Digital Economy)主任Erik Brynjolfsson研究了人工智能对未来工作的影响,Brynjolfsson在谈到未来几年可能被取代的适合机器学习的工作数量时表示:“如果你从整体经济的角度看,就会发现一个潮流即将到来。机器智能可以用来重新设计和增加工作场所的任务,但它最常被用来取代工作。”

布鲁金斯学会(Brookings Institution)的分析以及卡耐基梅隆大学的Brynjolfsson和Tom Mitchell的研究显示,自动化对失业的影响预计会因城市和州而异,此外就业不稳定或失业预计将对低收入家庭和有色人种造成不成比例的影响。麦肯锡最近的一份报告称,自动化将导致非洲裔美国男性的失业人数最多。

此前,美国的收入中位数自2000年以来一直停滞不前。Brynjolfsson将中位数收入增长与生产率增长的关系称为“大脱钩”。

他说:“在20世纪的大部分时间里,这些角色是相互关联的——更多的生产、更多的财富、更高的生产率——与普通人的富裕程度密切相关,但最近这些角色出现了分歧。蛋糕越来越大,我们创造了更多的财富,但这些财富聚集在少数人手中。"

Brynjolfsson认为,人工智能社区的挑战已经使美国国防部高级研究计划局(DARPA)的自动驾驶汽车挑战赛(autonomous vehicle challenge)和计算机视觉的ImageNet等最先进的人工智能领域实现了飞跃,但企业和人工智能社区应该开始将注意力转向共享繁荣。

“很多人可能会被甩在后面,事实上,很多人已经被甩了。这就是为什么我认为现在最紧迫的挑战不仅仅是更好的技术,尽管我完全支持,而是创造共同繁荣。”

科技巨头和权力之路

随着人工智能的普及,另一个主要的趋势是,在美国历史上第一次,大部分的劳动力是有色人种。根据美国人口普查局的预测,到2030年,美国大多数城市,乃至整个国家,将不再拥有占人口多数的种族。

这些人口结构的变化使得人工智能公司内部缺乏多样性的问题更加突出。至关重要的是,在决策系统的创建中缺乏种族和性别多样性——AI Now研究所所长Kate Crawford称其为“白人问题”。

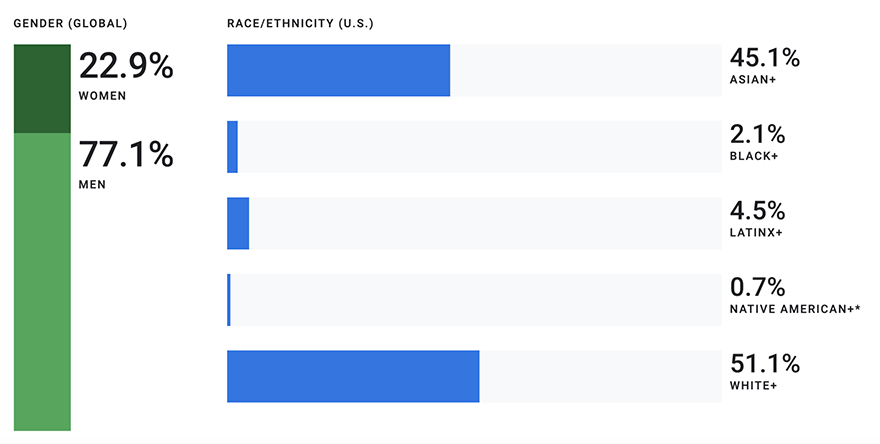

图片来源:谷歌2019多样性报告-技术劳动力代表的性别和种族统计

据《连线》和Element AI在2018年的一项分析显示,在大型人工智能会议上发表的研究中,女性只占18%,而Facebook和谷歌的研究人员中,女性只占15%和10%。两家公司的发言人表示,谷歌和Facebook不提供人工智能研究多样性数据。

AI Now研究所今年4月发布的一份报告详细描述了“负责技术研究的工程专业人群与部署人工智能系统的极为多样化的人群之间的鲜明文化差异”。该组织将其称为“人工智能问责差距”。

该报告还承认了人工智能系统中隐藏的人力资源,比如Facebook或YouTube内容所需的数万名版主,或者哥伦比亚的Kiwibot司机,他们正在旧金山湾区加州大学伯克利分校附近远程驾驶Kiwibot送货机器人。

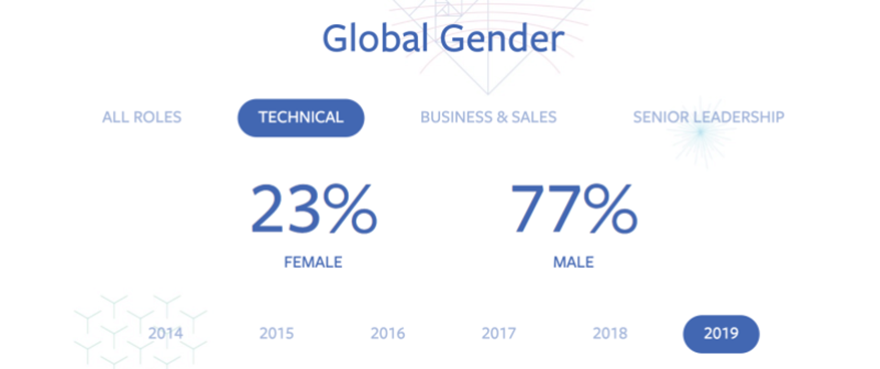

图片来源:Facebook 2019多样性数据-按种族划分的Facebook技术劳动力

报告称:“那些开发人工智能并从中获利的企业,与那些最有可能受到其负面影响的企业之间的差距正在拉大,而不是缩小。”报告指出,人工智能行业缺乏政府监管,权力集中在少数几家企业手中。

Safiya Noble博士和Sarah Roberts在今年8月加州大学洛杉矶分校发表的一篇论文中,记录了科技行业缺乏多样性的影响。他们认为,我们现在正在见证“数字技术统治的崛起”,实际上是一个储存资源的权力系统,它可能会根据种族身份、性别或阶级来判断一个人的价值。

“即使在联邦法律下,美国公司也无法‘自我调节’和‘创新’来结束种族歧视。在现代数字技术精英中,精英主义和智力优势的神话被用作种族和性别的象征,不成比例地从有色人种、尤其是非洲裔美国人、拉丁裔和印第安人那里整合资源,”报告写道。“对精英神话的投资压制了对种族主义和歧视的质疑,即使数字精英的产品中充满了种族、阶级和性别标记。”

尽管人们都在谈论如何解决科技行业的多元化问题,但科技行业的很多方面都只取得了渐进式的进展,对拉丁裔或黑人创业者的资助仍然落后于白人创业者。为了解决科技行业在多样性和包容性倡议方面普遍缺乏进展的问题,一对数据与社会研究员建议科技公司和人工智能公司采用种族扫盲。

其中之一,Mutale Nkonde,是《算法问责法》的合著者,该法案于今年早些时候在国会两院提出,要求联邦贸易委员会(FTC)对算法偏见进行评估,并允许该机构根据公司规模开出罚单。

她也是人工智能的执行董事,也是哈佛大学伯克曼·克莱因互联网和社会中心研究员。她现在正在评估人工智能和错误信息在2020年大选中如何被用来针对非洲裔美国人。参议院情报委员会(Senate Intelligence committee)去年10月发布的一项调查发现,干预2016年大选的举措只针对Facebook、Twitter和Instagram上的非裔美国人。

在此之前,她和一个小团队致力于推进种族扫盲的理念。

Nkonde和她的合著者认为,隐性偏见培训和多元化举措——由发布年度多元化报告的科技巨头们倡导的——并没有在创造一个看起来像用户的科技劳动力方面起到什么作用。为了取得有意义的进展,企业应该把模糊的愿望放在一边,开始采取切实的步骤,对人们进行种族扫盲教育。

一篇解释种族扫盲框架的论文写道:“在科技领域建立种族扫盲能力的真正目标,是想象一个不同的世界,一个我们可以打破旧模式的世界。如果不刻意解决技术领域的种族问题,新技术将不可避免地重现旧的分歧。但事实并非如此。”

合著者希望种族素养成为计算机科学学生课程和科技公司员工培训的一部分。他们的方法借鉴了霍华德·史蒂文森(Howard Stevenson)为学校提供的种族扫盲培训,并包括内隐联想测试,以确定人们持有的刻板印象。

种族扫盲旨在为人们提供培训,提升情商,以解决工作场所的种族压力状况。这可能包括计算机科学家和设计师,以及机器学习工程师,允许他们公开谈论一个产品或服务如何能使结构性种族主义永久化,或为不同的用户群体带来不利影响。

这样做的目的是让人们以一种开放和非对抗性的方式讨论产品或服务可能出现的问题。在对大中型科技公司员工的采访中,研究人员发现,在许多科技公司,与种族相关的问题是禁忌。

“人们想假装这无关紧要,而这实际上强化了种族主义模式和行为,”Nkonde说。“这将意味着,企业必须明确自己的价值观,而不是试图通过避免明确表达自己的价值观来迎合所有人。”

Nkonde认为,随着Alphabet等公司开发出对人们生活至关重要的产品,如医疗服务或出售给政府的面部识别软件,种族扫盲将变得越来越重要。

种族扫盲培训的另一个预期结果是,在公司内部创造一种文化,这种文化能在多元化的员工队伍中看到价值。波士顿咨询集团(Boston Consulting Group)去年发布的一份研究报告发现,多元化程度更高的组织拥有更高的收入和创新能力。但如果招聘和留任数据能说明什么问题的话,那就是硅谷的科技巨头们似乎还没有意识到这一点。

领英的高级软件工程师Guillaume Saint-Jacques认为AI伦理不仅仅是正确的事情,并且其在商业上是合理的。他认为,偏见会妨碍利润。

“如果你有很大的偏见,你可能只会迎合一个群体,最终这会限制你的用户群的增长,所以从商业角度来看,你希望所有人都参与进来……从长远来看,这实际上是一个不错的商业决策。”

个人自主和自动化

实力强大的公司可能会以不同的方式展示自己的实力,但它们的商业计划会对个人产生影响。

关于这种新的权力格局,或许最好的总结来自于哈佛商学院退休教授Shoshana Zuboff的《监控资本主义时代(Age of Surveillance Capitalism)》一书。该书详细介绍了一种新的资本主义形式的创造,该资本主义结合了诸如摄像头、智能家居设备和智能手机之类的传感器,以收集输入到AI系统中的数据,从而对我们的生活做出预测(例如我们将如何表现为消费者),以便“ 大规模了解并塑造我们的行为。”

“监视资本主义单方面宣称人类经验是一种免费的原始资源,可以转化为行为数据。尽管其中一些数据(洞见)被应用于产品或服务的改进,但其余的被宣布为一种专有的行为盈余,被输入称为‘机器智能’的先进制造过程,并被制造成预测产品,预测你现在、不久和以后会做什么,”Zuboff写道。

她认为,这种经济秩序是谷歌在硅谷创造的,但后来被亚马逊、Facebook和微软,以及百度和腾讯等中国同行采用。

Zuboff将监控资本主义描述为一种前所未有的权力形式,几乎没有人完全了解它,她还表示,目前没有有效的集体或政治行动手段来对抗它。

她质疑,当市场“转变为一个完全确定的项目”时,监管资本主义可能会对人性造成严重破坏。Zuboff说,如果不加以控制,这种相对较新的市场力量可以推翻人民的主权,成为对西方自由民主国家和“想象、意愿、承诺和建设未来”这一概念的威胁。

这些大公司“从我们这里积累了大量新知识,但不是为我们积累的。他们预测我们的未来是为了别人的利益。只要监管资本主义及其行为期货市场得以蓬勃发展,对新行为修正手段的所有权,就会使对生产手段的所有权黯然失色,成为21世纪资本主义财富和权力的源泉。”

Zuboff认为,监控资本主义的一个主要副产品是一种压倒性的无助感。这就是你看到的人们耸耸肩,说没有什么能阻止拥有大量资源和财富的大型科技公司。

泄密者爱德华·斯诺登似乎同意Zuboff的判断。

企业和政府越来越多地使用元数据收集来进行影响人类生活的决策,从使用移动设备跟踪用户的活动到中国的“社会信用评分”。斯诺登最近在接受美国全国广播公司(NBC)采访时被问及为何不犯罪的人应该关注监控技术,他说,这些数据的目的总的来说是为了消除个人的监控。

“这些活动记录被公司和政府不断地创建、共享、收集和拦截。最终,这意味着当他们出售这些,当他们交易这些,当他们在这些记录的基础上做生意,他们出售的不是信息。他们卖的是我们。他们在出卖我们的未来。他们在出卖我们的过去。他们出卖我们的历史,我们的身份,最终,他们偷走了我们的权力,让我们的故事为他们服务。”

普林斯顿大学副教授、《科技之后的赛跑(Race After Technology)》一书的作者Ruha Benjamin也关注代理问题,因为无论人们支持人工智能带来世界末日或乌托邦的愿景,他们都在谈论把权力让给机器。

Benjamin在肯尼亚内罗毕肯雅塔大学举行的深度学习会议上表示:“无论是技术将拯救我们还是杀死我们,它们都在放弃权力。”

在大公司内部出现了一个非常不同的个人权力的体现。例如,大约一年前,全球逾2万名谷歌员工因多种道德问题举行了罢工。据活动组织者介绍,其中包括Android创始人安迪·鲁宾在性骚扰指控后获得的9000万美元赔偿,强制仲裁的终结,以及谷歌参与五角大楼的Maven项目。

几个月前,数千名谷歌的员工签署了一封公开信,抗议该公司参与无人机目标探测的人工智能项目。几个月后,谷歌承诺在2019年终止其Maven合同,并发布了一套人工智能原则,其中包括不制造自动化武器的承诺。

同样,Facebook的员工呼吁首席执行官马克·扎克伯格核实事实,或禁止政治广告,而微软和GitHub的员工则呼吁终止与ICE的合同。

挑战大型科技公司需要勇气和组织——尤其是对那些受雇于这些公司的人来说——但这些抗议表明,个人可以重新获得一些权力,即使面对庞然大物也是如此。

政府和社会

随着人工智能在当今的复兴,埃隆·马斯克已经成为了当代的保罗·里维尔(Paul Revere),他发出了关于杀手机器人和人工一般智能(AGI)的警报。当俄罗斯总统弗拉基米尔·普京(Vladimir Putin)说控制人工智能的国家将控制世界时,马斯克回应称,他认为人工智能军备竞赛将导致第三次世界大战。

马斯克加入了4500多名人工智能和机器人研究人员的行列,并签署了一份为未来而战的公开信,反对无人干预的自动化武器。如果或当国家引进自主杀手机器人,拥有选择人类生死的权力,那可能确实会成为权力的最终表达。

然而,尽管像马斯克这样的人物把大量注意力放在了假设上,面部识别已经在某些城市得到应用,例如底特律警察局已经在测试实时面部识别。与此同时,算法返回的结果被认为对数百万非洲裔美国人的生活产生了负面影响,非二元性别和有色人种的表现很差。

像《终结者:天网》这样的AGI场景可能还没有出现,但军方已经在考虑人工智能的伦理应用。

人工智能、权力和公民社会

虽然围绕使用人工智能来控制网上政治言论的斗争仍在继续,但新问题仍在不断涌现,比如导致中介机构和倡导组织要求科技巨头禁止使用算法代替法官进行审前保释评估的偏见。

由苹果、Facebook和谷歌等公司的人工智能研究人员创建的人工智能伙伴关系,将大赦国际(Amnesty International)和人权观察(Human Rights Watch)等组织与世界上最大的人工智能公司联系在一起。执行董事Terah Lyons表示,在非政府组织和科技巨头就人工智能将如何影响社会展开的人工智能伦理辩论中,权力是核心。

她认为,人工智能行业缺乏多样性,对系统和工具的构建和部署方式也缺乏相应的影响力,以及科技公司和机构内部个人的权力和影响力,这些都是权力在起作用。

“与这些大型且资源丰富的科技公司相比,拥有少量资源的民间社会和非营利性机构的力量和资源配置存在许多差异,因此,更有效地赋予他们权力,我认为这是你开始为有效合作而公平竞争的重要因素。”她说。

同样的旅行限制也会影响有兴趣参加国际会议的人工智能研究人员。去年,在加拿大蒙特利尔的NeurIPS举办的人工智能研讨会上,大约有一半的与会者被移民局官员拒签,今年,申请者再次报告了同样的情况。

此类事件促使人工智能领域的合作伙伴敦促各国为人工智能研究会议的旅行提供特殊签证,就像在世界某些地区为医疗专业人士、运动员和企业家提供的签证一样。

国家与科技巨头之间的权力关系

Casper Klynge是丹麦驻硅谷大使。一些国家在旧金山湾区设有商业和创新中心,但Klynge是第一位被派往硅谷专门代表一个国家外交利益的大使。

丹麦政府已经派他作为全球超级大国与苹果、亚马逊、谷歌和Facebook等公司打交道,这些公司聚集了世界上大量的人工智能人才。Klynge认为,更多的小国也应该这样做,这样它们才能为共同的目标而共同努力。Klynge说,在他担任北约秘书长的两年中,他了解到与其他小国建立多边联盟是他工作的一部分。

垄断企业对政府来说并不新鲜,但Klynge表示,像自动驾驶和搜索这样的人工智能已经改变了游戏规则,使这类科技公司对国家利益的重要性超过许多其他国家,并引发了对丹麦所称的技术外交的需求。

Klynge指出,科技巨头正在扭曲国际关系的本质,并在创造一个新的现实,即各国必须像对待全球超级大国那样对待科技巨头。

“我们不能再把它们看作是中立的平台,它们只是人们想做的事情的中立提供者。我认为,我们必须以更成熟和负责任的方式对待他们,这也意味着我们不再幼稚,我们更加平衡,我们也提出要求,让他们负起责任。”他说,“我的工作只是一个症状,我们正努力做一些更系统化的事情,以对科技公司和科技本身有一个更平衡、更现实的看法。”

未来又是如何?

在有关人工智能伦理的辩论中,权力无处不在,但这并不意味着我们必须保持无作为。正如种族扫盲项目所表明的那样,还有另一种方式。

当Ruha Benjamin说科技需要的是“社会上的想象力”时,她就呼吁这样做。Cathy O 'Neil在她的著作《数学毁灭的武器(Weapons of Math Destruction)》中也提到了这一点。

“大数据流程编纂了过去。他们没有创造未来。这样做需要道德想象力,而这是只有人类才能提供的东西,”她写道。

一种扭曲的权力格局使得“民主化”之类的词汇实际上毫无意义,但将人工智能交到解决重大问题的更多人手中,可能会显著改变人们对人工智能的看法,并在人类生活中产生积极影响。

当然,已经有很多人工智能被用来改善人类生活的例子。麻省理工学院的研究人员发明了一种让孩子们更快上学的算法,每年为波士顿学区节省了500万美元的交通费用。纽约消防局和纽约大学正在利用人工智能,通过了解最有效的现场路径来提高应急响应时间——这是Google.org上几十个项目之一,它们采用数据驱动的方法来创建人工智能,造福人类。人类正在利用人工智能建造更高效的温室,提高农作物产量,这些进步可能有助于在未来几十年避免饥饿,并在全球人口膨胀至100亿之际养活世界。这样的例子不胜枚举。

但是,能够预测未来、颠覆经济和社会秩序、把人关进监狱、或者对我们的健康做出决定的技术,总是意味着,在令人印象深刻的技术进步的表面之下,是一场权力斗争。

在人工智能系统中存在一种权力动态,它会让有色人种在保释评估、影响数百万人的医疗保健、无家可归者服务和面部识别方面的表现更差。

当欧盟的人工智能专家敦促各国避免大规模监控,而是使用人工智能来增强人们的能力时,也会出现这种情况。三星和联合国都提出了利用人工智能实现可持续发展目标的倡议。

正如数字中心丹麦的首席执行官Camilla Rygaard-Hjalsted所说的那样,积极的气候变化目标有助于招募人工智能人才,或者机器学习应用于气候变化可能是人工智能的伟大登月计划。

它存在于刚刚起步的人工智能对话项目中,以保护军人的孩子,探测何时可能发生团伙枪击,或者为巴基斯坦的少女提供性健康咨询服务。

它存在于开源项目中,比如Masakhane,它致力于为2000多种非洲语言创建机器翻译。该项目目前有来自非洲大陆各个角落的60名贡献者,他们致力于开发能够保存和翻译这些语言的人工智能。据联合国估计,非洲拥有地球上最年轻的人口,从现在到2050年,非洲将占全球人口增长的一半以上。非洲的机器翻译对于推动人工智能对话、交流以及在线和现实世界中的商务可能很重要。

在过去的三年中,Kathleen Siminyu一直在肯尼亚内罗毕的机器学习和数据科学女性分部工作。她说:“我认为语言是一个障碍,如果消除了这个障碍,很多非洲人就能够参与数字经济,并最终进入人工智能经济。所以,是的,作为坐在这里为本地语言做贡献的人,我觉得我们有责任把那些不在数字时代的人带入人工智能时代。”

如果你只关注人工智能伦理辩论的一部分,很容易得出这样的结论:让人工智能伦理成为工程和设计过程的一部分,在政治上是正确的,是企业社会责任的要求,可能会阻碍真正的进步。

其实不是。人工智能伦理意味着尽可能以最好的方式建立模型,把人类考虑在内,让模型处于循环之中,这对于未来的技术和人们选择的管理世界的系统来说是不可或缺的。

当我们对未来没有其他的愿景,除了一个处于全球监视状态、走向第三次世界大战的失业星球之外,没有其他的可能性时,这些权力动态似乎最令人生畏。

在描绘通往更美好世界的道路时,必须认识到其中的权力动态,因为就像人工智能本身可以是工具或武器一样,它可以使个人和整个社会处于有利或不利的地位。创业公司、科技巨头和希望有一个更美好世界的社区有责任梦想并分享这些愿望。

人工智能正在改变社会,它不可能只是少数有特权的人来决定这将如何发生或构建这个世界的样子。

作者:汤圆圆来源:猎云网