瑞莱智慧参评“‘维科杯’·OFweek2020(第五届)人工智能行业优秀产品应用奖”

“‘维科杯’·OFweek 2020(第五届)人工智能行业年度评选”活动由高科技行业门户OFweek维科网主办,OFweek人工智能网承办,活动旨在表彰人工智能领域具有突出贡献的优秀产品、技术及企业,鼓励更多企业投入技术创新;同时为行业输送更多创新产品、前沿技术,一同畅享人工智能的未来。

2020人工智能行业年度评选“OFweek (5th.) AI Awards 2020”将于2020年9月21日-10月10日进入网络投票阶段,颁奖典礼将于10月28日在深圳举办。

目前,活动正处于火热的报名评审阶段,业内企业积极响应。瑞莱智慧已正式参评“维科杯·OFweek2020(第五届)人工智能行业优秀产品应用奖”。

瑞莱智慧RealAI是依托清华大学人工智能研究院设立的人工智能企业,是国内首家安全可控人工智能技术及行业解决方案提供商,先后推出RealBox鲁棒机器学习平台、RealSafe人工智能安全平台等自研平台以及更加安全可靠的行业解决方案,致力于建设安全可控人工智能应用新生态。

参赛产品/项目名称:RealSafe人工智能安全平台

推出年份:2020/04

开发背景:近年来,以机器学习尤其是深度学习为代表的人工智能技术的取得了快速发展与广泛应用。然而,当前以数据驱动为代表的第二代人工智能技术还存在着巨大的安全风险,当前人工智能系统被入侵的风险主要是对抗样本攻击与模型攻击。

(1)对抗样本攻击

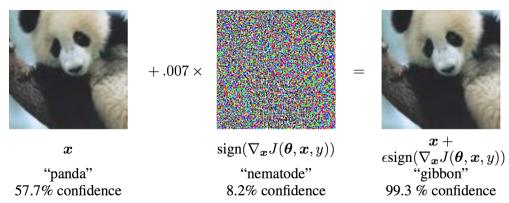

对抗样本(Adversarial Examples)是指在数据集中故意添加细微的干扰所形成的输入样本,会导致模型以高置信度给出错误的输出,从而导致AI系统判断失准。如图1所示,通过对图像添加微小的扰动,构造对抗样本,从而欺骗在正常样本上工作良好的深度学习图像分类模型,被攻击过的熊猫图像被深度学习模型以高置信度认为是长臂猿。

图1:对抗样本

(2)模型攻击

通过在训练数据中添加少量投毒数据的方式在模型中埋藏后门,埋藏好的后门通过攻击者预先设定的触发器激发。在后门未被激发时,被攻击的模型具有和正常模型类似的表现;当模型中埋藏的后门被攻击者激活时,模型给出错误的输出。如图2所示,通过事先修改训练数据在模型中埋藏后门,模型在正常样本上表现正常,一旦遇到黄色像素块、炸弹、花朵图案作为触发器后门被激发,就会将停车标志错认为减速标志。

图2:模型攻击

为了提升人工智能系统的安全性,有效抵御对抗样本攻击、模型攻击等风险,RealAI推出RealSafe 人工智能安全平台,通过集成主流及独有世界领先对抗样本攻击与防御、模型后门检测算法,提供业界首个可视化零编码模型安全测评及防御升级升级平台。

核心技术介绍:

RealSafe人工智能安全平台包括大功能模块:模型安全评测、防御解决方案,支持用户创建和管理自定义的数据集用于模型安全测评与防御升级。

模型安全评测模块提供对抗样本风险检测与模型后门检测两大功能,在进行对抗样本安全风险测评时,平台将基于多种算法生成对抗样本模拟攻击,并综合在不同算法、迭代次数、扰动量大小的攻击下模型效果的变化,给出被测AI模型的安全评分及详细的测评报告;在进行模型后门检测时,平台将通过高维空间搜索的方式,检查模型是否存在后门,若存在后门,还支持还原出模型学习到的触发器信息。

模型安全评测结果,用户可自行选择合适的防御方案,一键提升模型安全性。目前RealSafe平台支持五种去除对抗样本噪声的通用防御方法,可实现对输入数据的自动去噪处理,破坏攻击者恶意添加的对抗噪声。

RealSafe平台提供从安全测评到防御加固整体解决方案,目前可用于发现包括人脸比对、图像分类、目标检测等应用场景下常用算法模型可能出错的极端情形,同时也能预防潜在的对抗攻击、模型恶意攻击。

参评述说/理由:

在人工智能技术快速发展与广泛应用的当下,人工智能安全问题变得尤为紧迫。虽然AI安全仍是一个新兴领域,但对抗样本、数据投毒等攻击手段在开源社区、工具包的加持下变得愈发可实现,甚至于实质性的危害已经开始产生,但与之相对的,相关防御手段的普及和推广却一直没有跟上,主要原因在于对抗样本等安全攻防技术存在较高的技术壁垒,只有极少部分的顶尖算法人才掌握这部分的能力。在这一背景下,RealSafe平台作为一款自动化检测工具,大大降低了模型安全检测与防御升级的技术难度,能够帮助大部分不具备该领域专业技能的企业与组织高效应对日益增长的恶意攻击,有效提升人工智能系统的安全性、可靠性。从这一角度来看,RealSafe平台可以说是划时代的颠覆性产品。

本届“‘维科杯’·OFweek 2020(第五届)人工智能行业年度评选”活动将于9月21日进入网络投票阶段,欢迎各位踊跃投票!