英特尔宋继强:坚持科研的长期主义 推动AI向3.0时代跃迁

最近几天,新冠疫情在北京再次升级,使总体向好的国内抗疫形势变得严峻。刚刚重启的生产生活被再次打乱,我们或许在未来较长一段时间内都不得不面对防疫常态化这一现实。本周,我又开始切换到“云办公、云生活”的状态。远程办公、视频会议已成习惯,孩子的课业交给了在线教育平台,消费和娱乐的方式也变成了看网络直播、听云演唱会。在疫情这一特殊的场景下,一系列新型AI应用需求被全面激活,AI真正渗透到了我们日常生活的方方面面。

作为一个科技从业者,我深知这些AI新应用的爆发绝非一日之功。从量变到质变的过程,是长期的科研布局与数字化基础设施建设的结果。瞄准长远的目标与价值,坚持长期的科技研究,是我们面对“疫情”这样不确定事件时唯一确定的事情。这不仅需要前瞻性的视野与布局,还需要有不为眼前利益所动摇的决心与意志。

从AI的发展进程看,人类对于AI的探索已经持续了70多年。回望AI的发展历程,我们可以清晰地捕捉到几个关键的节点。AI第一波浪潮,是通过由人制定的各种规则去做理论性的推理。虽然在推理方面表现不俗,但仅限于几个严格定义的问题,且没有学习能力,无法处理不确定性问题。而真正令AI渐入佳境的,则源于由深度学习所触发的AI第二波浪潮。互联网、移动互联网等所产生的海量数据,给机器提供了学习、挖掘和试错的对象,让系统得以自发地找到“规律”,作出预测、判断和决策。数据的增长,外加算力的提升以及基于深度学习构建的算法演进,这三张“王牌”让一些典型的深度学习应用达到甚至超越了人的能力。这使得越来越多的乐观主义者深信,深度学习是极具价值且值得产业界大规模跟进的方向。

然而,深度学习就是AI的终极答案吗?随着对于深度学习的研究深入,我们发现还有一些问题亟待解决。首先,“能耗”是最大的挑战。有研究报告显示,采用服务器级别的CPU加上GPU集群去训练一个大型AI模型,其所消耗电力产生的碳排放量,相当于5辆美式轿车整个生命周期所消耗的碳排放量。试想,如果各行各业都沿用这样的AI计算模式,人类的生态环境将会遭到何等的破坏。然后,“数据量”是又一大挑战。目前的深度学习过于依赖大数据,在一些小数据量的场景下,深度学习使用会非常有限。AI应该像人类大脑那样,通过小数据进行自我学习。在训练过程中,如何在保证AI模型能力的情况下,大幅降低能耗并减少所需花费的时间和数据量?这是AI继续向前发展的重要方向。但现在看来,基于大规模GPU并行计算去加速深度学习训练的方式,并不能满足这个条件。

一个真正的智能系统,应该是环境自适应性的“自然智能”。首先,它不仅能处理确定性的问题,还能处理不确定性问题。第二,它不仅能够做事,还必须是可解释的。第三,它不完全依靠大数据驱动,即便少量数据也可实现更高效能的持续学习。第四,它应具备高可靠性,或者说符合人类给它设定的伦理道德。这是我们对于AI技术下一发展阶段——AI 3.0时代的展望。

目前,我们正处于从AI 2.0到AI 3.0时代的转折点。那么,究竟什么有望成为穿透AI未来的“利刃”呢?从目前看,作为一种前沿的计算模式,神经拟态计算最有可能开辟出一条从AI 2.0到AI 3.0的崭新赛道。神经拟态计算,是在传统半导体工艺和芯片架构上的一种尝试和突破。它通过模拟人脑神经元的构造和神经元之间互联的机制,能在低功耗以及少量训练数据的条件下持续不断自我学习,大幅提高了能效比。显然,神经拟态计算的特点非常符合AI3.0的发展需求。因此,神经拟态计算也被寄予厚望,有可能在人类迈入下一代AI的进程中发挥重要作用。

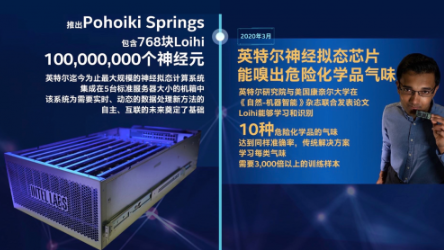

英特尔是一家立足长远、推动底层技术创新的公司,以此来帮助客户取得商业应用上的成功。为此,我们不断对前沿技术领域加大研究,即便这些领域在短期内无法看到实际成效。围绕神经拟态计算,我们从很早就开始积极探索这一崭新的计算模式,并取得了令人瞩目的成就。英特尔的神经拟态计算芯片Loihi已经具备了嗅觉的能力,神经拟态系统Pohoiki Springs已经拥有1亿神经元的计算能力,这已经相当于一个小型哺乳动物的大脑。

当然,神经拟态计算还处于非常早期的阶段,要想将这项技术真正应用于AI,我们还有很长的路要走。但我相信,底层技术的创新必须坚持长期主义,长时间地专注于一个方向与赛道,以这种确定性去对抗发展过程中的一切不确定性,才有可能最终取得成功。