解读针对新冠病毒事件的社交距离和口罩检测

磐创AI摘要该主题包括针对新冠病毒事件的社交距离和口罩检测,可以通过保持社交距离以及戴上口罩来缓解这种流行病。Covid-19对许多国家产生了巨大影响,这种影响给世界各地的许多人造成了问题。由于可以减轻病毒的传播,因此戴上口罩以及保持社交距离可以挽救很多生命。YOLO(You Only Look Once)表示你只看一次,该算法用于对象检测和对象跟踪,本研究使用YOLO在对象检测的帮助下计算人脸的社交距离和识别口罩,同时跟踪人脸,通过对象跟踪完成对对象进行计数并在下一帧中保留该对象的记录中的步骤。保持社会距离的同时保持的最小距离为6英尺,以此作为计算距离的基础,该模型经过训练,可用于对象检测和对象跟踪。可用的算法类型不同,YOLO目前在所有其他算法中脱颖而出。

自定义数据集用于了解口罩,并在这些数据集上进行了训练以进行检测和跟踪。为了评估训练后的模型,针对两个用例(社交距离和口罩检测)都计算了mAP(平均精度),该方法通过将真实边界框与检测到的框进行比较来进行工作,最后返回分数。mAP得分越高,目标检测的模型越好。介绍计算机视觉是人工智能的子集,它利用计算机的能力从提供的数据集中提取有意义的信息,这些数据集可以是图像,视频等。计算机视觉的这种使用可以扩展到许多其他应用程序,具体取决于用例。

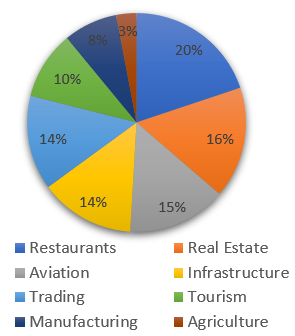

人工智能可以说是涵盖了机器学习,深度学习和计算机视觉等方面的“棚屋”。这项基于“口罩检测和社交距离”的研究使用计算机视觉,来理解图像或视频的各个方面,并将其作为算法的输入。这背后的基本概念是找到与类有关的边界框,根据训练数据集,类的范围可以是从Dog到Car的任何范围。新冠病毒对世界各行各业,包括工业,交通运输或农业产生了巨大影响,这种影响导致世界停止了每个部门,并遵循严格的限制措施,优先进行社交疏散和戴口罩。Covid-19对不同行业的影响可以在下面的图1中看到。

图1 影响分布的饼图

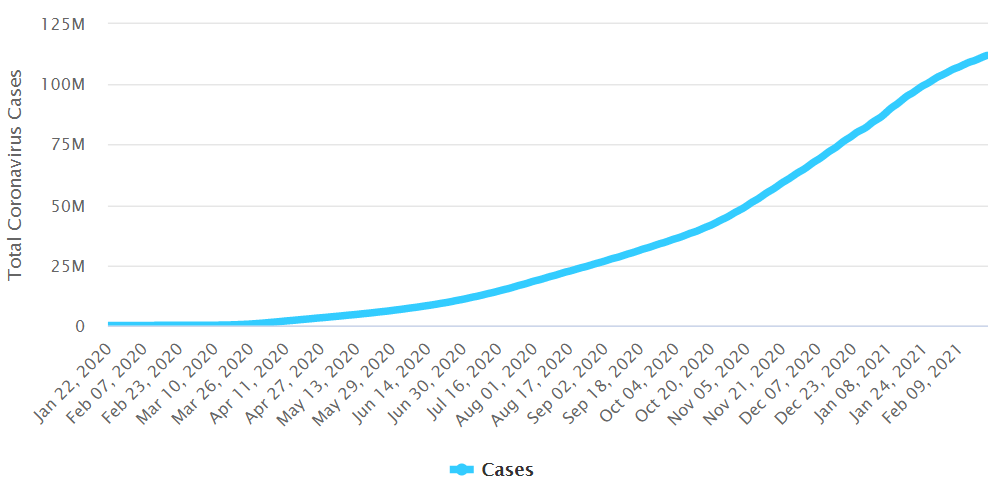

可以看出,对餐饮业的影响最大,其中20%的百分比最高,其次是房地产(16%)。同样,可以看出,Covid-19的影响最小的是农业部门(3%)。从图2可以观察到全球范围内的新冠病毒总数,该图显示了根据时间戳记受Covid影响的人群图。

图2.全球共有的Covid病例

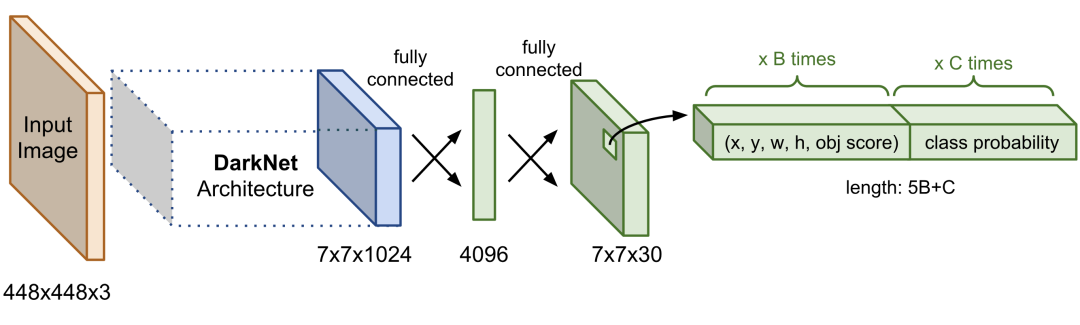

可以观察到,病例开始于2020年1月22日左右,图表呈指数增长,从0例增加到2021年2月9日的约1.11亿例。Covid的上升正在以不同的数字影响所有国家,如此巨大的数字是毁灭性的,并导致了这种流行病向大流行病的转变。方法这一部分重点介绍了用于对象检测和对象跟踪的算法。1. YOLO的体系结构Yolo算法代表“你只看一次”,它是一种先进的技术,它在实时系统上运行,以深度学习为基础,可以解决各种对象检测以及对象跟踪问题。可以从下面的图3中观察到Yolo的体系结构。

图3. YOLO架构

从上图可以看出,该体系结构包含“输入”图像层,这些层负责获取将传递给其他层的输入,根据使用情况,输入可以是任何图像。沿着输入层进入DarkNet架构,这是一个开源神经网络,其框架是在C&CUDA的帮助下创建的,该框架具有用于对象检测和对象跟踪的YOLO。此外,该体系结构由与卷积层紧密连接的flatten层组成,该卷积层也紧密连接以将数据从每个节点传递到体系结构中的其他节点。

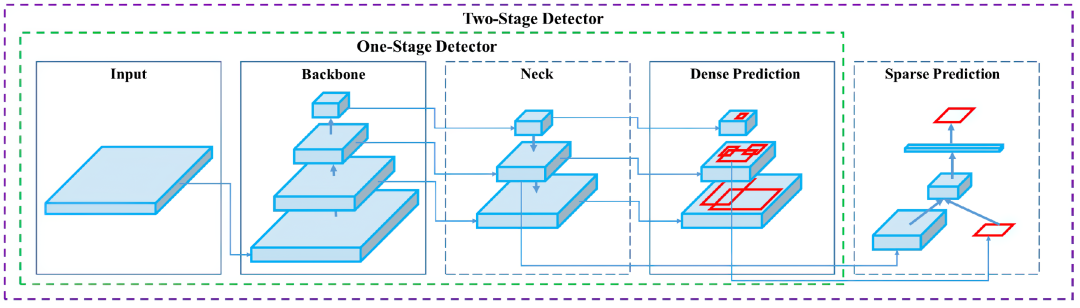

类似地,它被传递到输出层,该输出层分为4部分值,这4个部分描述了边界框的预测值(用x,y,w,h表示),以及对象检测分数以及预测类别的概率。该YOLO是精确快速的“one-stage”对象检测器系列的一部分,还有“two-stage”对象检测器。流行的两阶段目标检测器是R-CNN,Fast R-CNN和Faster R-CNN,这些算法可以根据特定用例准确地获得结果,但与Yolo相比,速度较慢,一旦有一种算法可以一目了然地查看图像,并基于该外观预测与某些类别相关的边界框,则类别可以是从Dog到Car或Gun到Tanks的任何内容,此特殊功能使Yolo脱颖而出。在下面的图4中可以观察到基于镜头的不同类型的对象检测器。

图4.不同类型的探测器

从上图可以发现不同的组件,有4种不同类型的组件:input 根据研究中指定的用例,检测器的输入可以是图像或视频。Backbone 目标检测器的骨干包含模型,这些模型可以是ResNet,DenseNet,VGG。Neck 检测器中的颈部充当额外的层,与骨干和头部平行。Head 是负责检测基于边界框的对象的网络。实验结果该项目的实验结果部分详细介绍了进行各种观察并形成最终输出后获得的结果。该项目的重点是针对Covid-19事件的社交距离检测和人脸口罩检测。图5解释了计算对象之间距离的体系结构,并显示了如何使用Yolo Version 4生成输出。

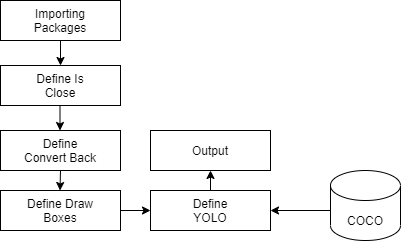

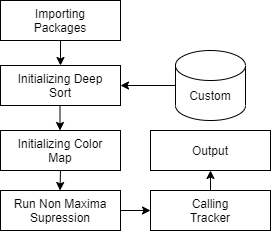

图5. YOLO Darknet架构

下面的图6是用于分析对象上的口罩的体系结构,此处的对象是在自定义数据集的帮助下执行检测的人员。根据提供的注释,对自定义数据集进行了3个不同类别(好,无和坏)的训练,它将框与各自的类别绑定在一起。对象检测和对象跟踪之间的区别在于使用了跟踪器(在Yolo DeepSort中),该跟踪器通过分配ID来帮助跟踪对象。

图6. YOLO Deepsort体系结构

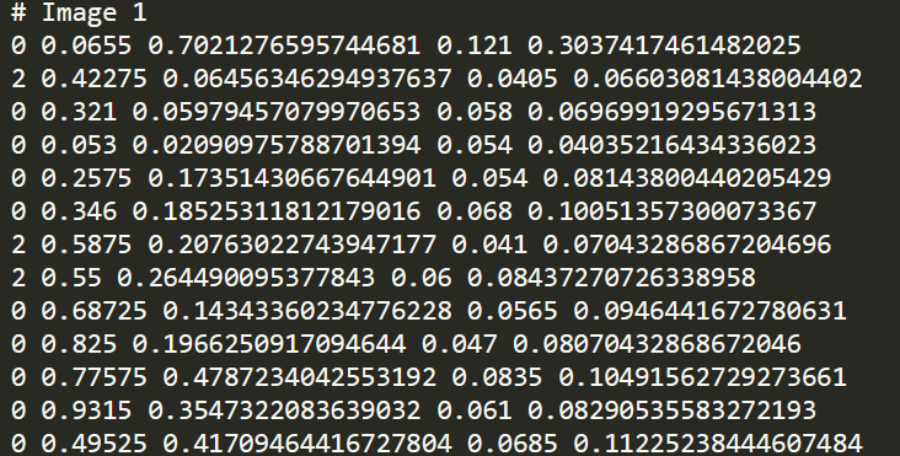

以下是用于训练目的的数据集的示例。从图7可以看出,该图显示了基于COCO数据集的人的检测,该数据集包含从Cat到Car到Person的大量类别。

图7. COCO数据集样本

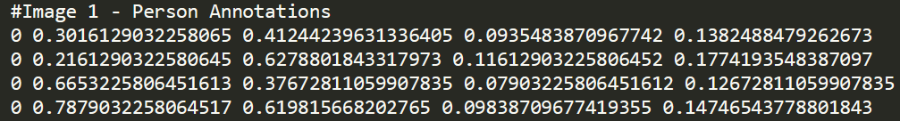

同样,下面的图8显示了用于人脸口罩检测的自定义数据集,该自定义数据集包含600张图像,并对帧中存在的每个对象进行了注释。之所以需要创建自定义数据集,是因为COCO数据集不包含用于检测口罩的类。

图8.自定义数据集样本

根据上图,为框架中存在的不同类别创建了注释。从图9可以看出,它包含2个不同类别(0和2)。用于口罩检测的类分别为0(好),1(无)和2(坏)。

图9.基于图像的对象注释

类似地,另一个注释文件是基于“人物对象检测”创建的,用于基于框架中检测到的对象创建边界框。从下面的图10可以看出,它包含一个类(Person为0),社会距离的输出目标是检测帧中的人,并根据与另一个对象之间的距离来计算度量。为了计算对象之间的距离,使用了欧几里德距离公式。

图10.基于图像的对象注释

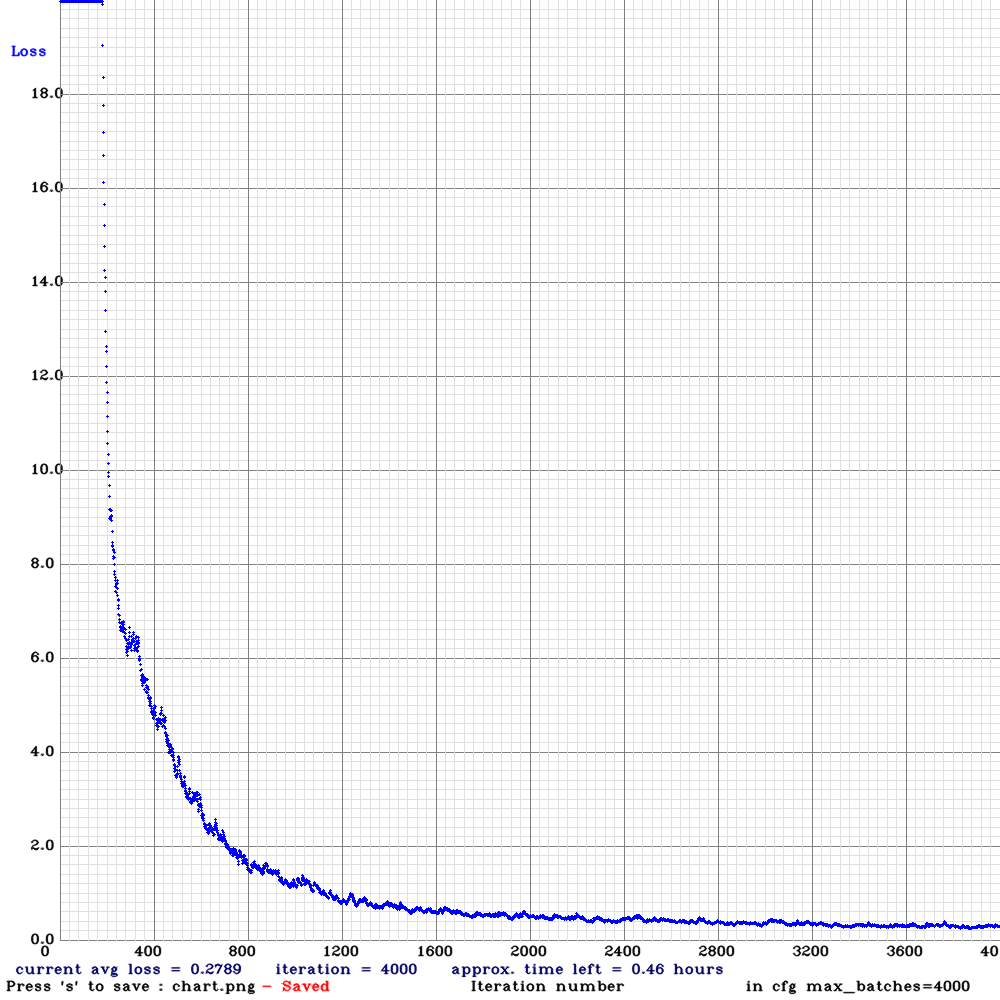

下图是用于训练自定义数据集的训练图,该研究中使用的自定义数据集与口罩有关,其训练的时期为4000个时期。从图11可以看出,损失在1200个时期后逐渐减少,并且在最后一个时期期间保持不变,这说明训练损失被最小化到1200,此后一直保持不变,这意味着应该将训练时期设置为2000左右,因为在数据训练中出现的迭代次数越多,执行时需要更多的计算能力。

图11.用于训练自定义数据的迭代图

与基于社会距离的研究有关的结果如图12所示,结果网格化为2个图像,图像的左侧表示基于距离计算的带有相应边界框的输出。

图12.社交距离检测

类似地,该项目进行了Face Mask检测,结果如图13所示,该图分别显示了用边界框检测到的对象,目标是根据其创建的对象来检测对象(Face)是否戴着口罩。一个具有不同颜色的边界框,并显示与之关联的类名称。使用的颜色是:绿色表示无口罩,紫色表示有口罩。

图13.拥挤场所的口罩检测

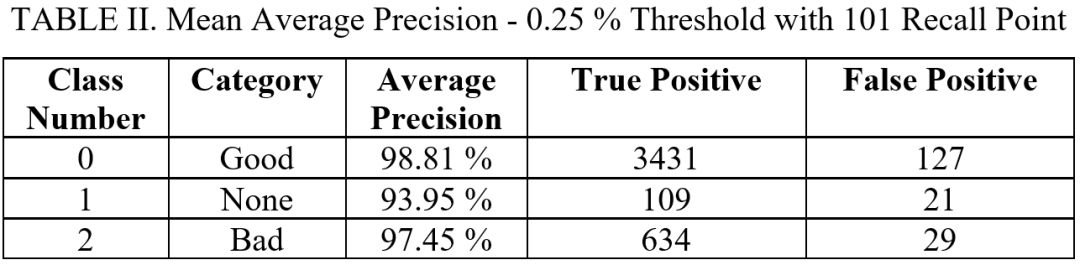

另一个与使用Darknet进行面部 口罩检测有关的示例如图14所示,该Darknet的实现基于“对象检测”,没有在不同帧中跟踪对象。可以观察到该模型检测到的对象戴着“ No Mask”,仍然分配了一些具有“good与bad”的对象,以及“No Mask”的未命中分类的对象被分配了“good”类别,这些假阳性结果将在表II中进行说明。

图14.口罩检测的另一个示例

最后,为了评估基于提供的数据集的模型训练,并使用mAP(平均精度)进行了评估,该方法基于平均精度的计算,而所有计算均基于训练数据中存在的类和总体IoU(交集超过交集)阈值。下表I显示了每个类别的平均精度,以及通过“真阳性”和“假阳性”获得的值。用101个召回点计算的AP的阈值百分比为0.25%。

从上表可以看出,每个类别的 AP 类别百分比都超过90%。结论这项研究的目的是了解Covid-19事件的社交距离和人脸口罩检测,社交距离的对象检测基于人,而人脸口罩检测基于人脸,这是使用Yolo完成的。用于目标检测的Yolo v4是由Darknet进行的,而对象跟踪是由Deepsort进行的。通过计算mAP进行了最终模型的最终计算,该模型对对象的预测有多好,这表明对于0.25%的阈值,平均精度约为90%或更高;对于0.50%的阈值,平均精度约为30%。88%及以上。同样,在不同的视频数据集上进行了社交距离的输出,为增加检测的复杂性,还考虑了拥挤的场景。口罩跟踪模型显示了每个检测到的对象的百分比精度。这可以在具有实时检测功能的大型行业中进行,而这需要更高的计算能力。