中科大&微软提出挑图神器: GIQA,一键挑出高质量图像!

将门创投

在做生成模型时,用一个生成网络生成了一批图,为了挑选几张最好的做demo,可能要花费大量的时间精力。为了解决该问题,中国科学技术大学在读博士古纾旸等人提出了一个全新的研究方向:生成图片质量评估(GIQA)。通过对单张生成图片质量的打分,我们可以“一键”挑出高质量的图。

本文首次提出对生成模型生成图片的质量进行定量,客观地衡量这一新的研究课题,并提出了几种解决方案和一个数据集去衡量这些方案。通过丰富的实验证明了这个课题有了宽广的应用。

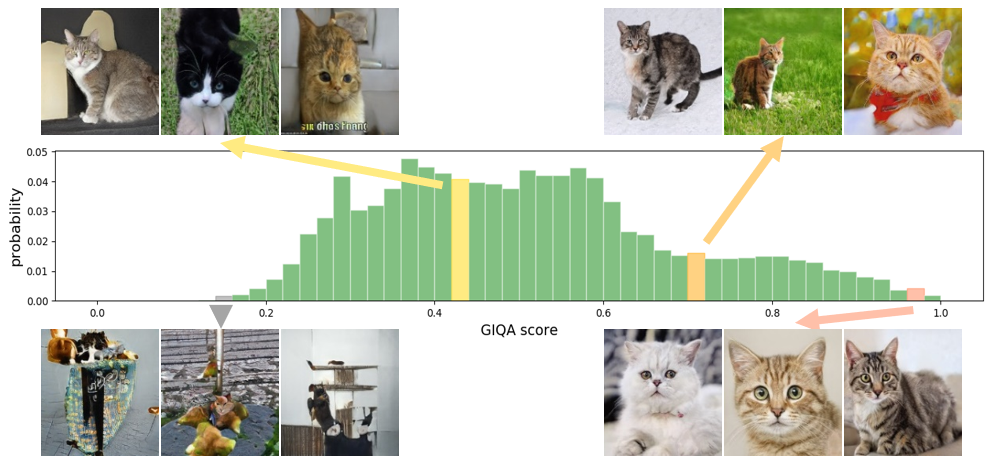

这些年来,深度生成模型取得了巨大的进展,诞生了很多有趣的应用,然而,并非所有生成的结果都很完美。如下图所示,图中四个角上的图片均为StyleGAN在一只猫的数据集上生成结果。在这些图片中,既有很多高质量的猫(右下),也有很多图质量很差(完全看不出来是猫,左下)。

以往大家为了评估哪张图生成的好,往往都是要靠人来判断,这需要花费大量人力成本。在实际应用中,由于对于生成图片的最差质量缺少把控,很多产品遭受到了各种质疑。基于此,我们提出了生成图像质量评估(GIQA)这一研究方向,并希望用评估算法对生成图片的质量进行自动的打分。为了实现这个目的,我们从基于学习的和基于数据的两个角度提出了三种解决方法,利用这些方法,我们能够实现对生成图片的质量进行打分,同时实现很多有趣的应用。上图中展示了我们对一个模型的生成图片进行打分的分布结果,在右下、右上、左上、左下中我们分别展示了模型评价的从高质量到低质量的生成图片,可以观察到我们算法评价的质量基本上和人的评价是一致的。

下面将介绍我们是怎么实现用算法进行生成图片质量评价的。

基于学习的GIQA

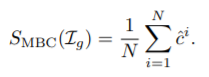

我们发现,在训练GAN的时候,生成图片的质量会随着迭代次数的增加而变好。一个简单的想法是用迭代次数当质量的“伪标签”,通过监督式的学习,来学一个打分器,对生成图片的质量进行打分。然而,用迭代次数当质量并不精确,我们通过多个二分类器(Multiple binary classifiers)回归标签来平滑去噪,通过平均这些分类器的分数,可以极大的增强鲁棒性和泛化能力。我们称之为MBC-GIQA。

数据驱动GIQA

我们重新思考质量评估这个问题,发现“质量”很难定义好。生成模型希望能生成服从已有的真实数据分布(real distribution)的图片,因此,我们认为“质量”表征的是一张生成图片和真实数据分布的接近程度。通俗的说,就是一张生成图片有多大可能性来自于真实分布。这个概率越大,表示质量越高。因此,另一个直观的想法是对真实分布直接建模。我们根据建模是参数化模型还是非参数化模型分成两部分。

参数化模型:GMM-GIQA

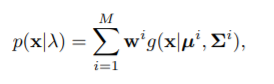

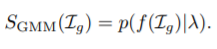

我们将用高斯混合模型(GMM)来拟合真实数据分布在特征层面的特征。对于一张待测的图片I,我们先提取他特征x,这个特征x在真实数据分布中出现的概率就表示了该图的质量。

1 2 3 下一页>