Vision Pro交互设计,苹果的阳谋

VR陀螺

文/VR陀螺 元桥

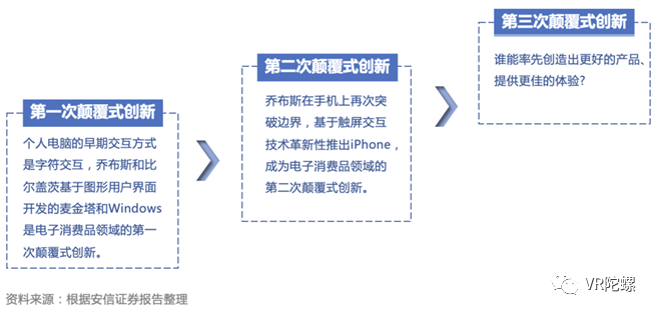

距离苹果发布新品已过半月左右,但库克登场说出的那句话“正如iPhone带我们进入移动计算时代,Apple Vision Pro将带我们进入空间计算时代”,仍让人感到兴奋。

兴奋的不仅仅是我们或将迎来的新时代,更有这款产品的交互设计对当下头戴设备的影响。在Vision Pro发布半个月的时间中,可以看到诸多体验过Vision Pro的博主都对这款产品的交互设计表示甚为惊喜;VR陀螺近期也与诸多业内人士展开深度交流,能感受到大家对于苹果的交互设计也都一致表示震感。

毕竟Vision Pro摆脱了「手柄」外部操控器,用户仅通过眼睛、手、语音便可与设备进行交互,并且眼动、手势与语音之间是打通的,是一整套的交互方式。

毫无疑问,苹果在重新定义MR交互方式的标准,而从每个技术上来看,Vision Pro又是苹果多年来布局的一个体现。

从初代iPhone,看Vision Pro的交互设计

乔布斯是一位为产品设计而疯狂的人,在每一个步骤上,他都会推进删除与简化,小到一颗螺丝钉的布局都要经过几个回合的筛选;由此,苹果一直都以其精湛的硬件与软件的设计、极简的风格而闻名全球。

在设计苹果系列产品时,乔布斯曾说“我们的设计思想就是「极致的简约」,我们管理公司、设计产品、广告宣传的理念就是一句话——让我们做得简单一点,真正的简单。”

2007年第一代iPhone发布,乔布斯在演讲中说道:

“今天我们要推出三款同级别的革命性产品。首先是一台带触控的宽屏iPod,其次是一部革命性的手机,还有一款具有突破性意义的互联网通信设备。所以,是三样东西:一台带触控的宽屏iPod,一部革命性的手机,一款具有突破性意义的互联网通信设备。一台iPod,一部手机,一款网络通信器……你们明白我在说什么吗?这不是三台独立的设备,这是一台设备,我们叫它iPhone”。

苹果为了初代iPhone的到来,研发了2年多的时间。就在乔布斯登台之前,他还召集了其团队,告诉他们要记住那一刻,也就是iPhone问世之前的那一刻。因为,下一刻,一切都会改变。

确实,第一代iPhone的设计,多点触摸功能的屏幕彻底改变了传统手机按键式操作,打开了智能手机世界的大门,并且在后续机型中引入的App Store,让手机成为了真正的移动智能终端,主导了当时的黑莓、摩托罗拉等智能手机。

与第一代iPhone同年发布的黑莓Curve 8310,因为实体键盘挤占了空间,所以屏幕只有2.5英寸

再回看Vision Pro的交互方式就如同iPhone的多点触摸功能设计,摒弃了多余的工具,更加贴近人体的自然习惯,让人类自己成为自然的交互工具,更重要的是Vision Pro让头戴设备充满了「科幻的魅力」。据称,Vision Pro的交互简单到用户只需要1分钟就能适应甚至零成本的学习,界面极度丝滑,窗口就像真实世界中的运动轨迹一样。

视线扫过时的细腻动画效果,图源:苹果

在Vison Pro发布之后,扎克伯格曾对苹果头显发表了自己的看法,他认为「苹果Vision Pro并没有实现Meta未探索技术领域的任何重大突破」。其实不仅扎克伯格这么看,业界几乎也认为Vison Pro并没有带来创新。但能够看出Vision Pro并不重在发明,它的每个点都让人惊喜,亦是一种创新。在技术上来看,Vision Pro几乎颠覆了第三次人机交互的创新,对于人机交互的发展来说,迈出了极大的一步。

《时代》杂志作家格罗斯曼在iPhone发布之后,曾一针见血的指出“iPhone并没有真正发明许多新的功能,而是让这些功能实用很多。这很重要,如果工具不顺手,我们往往会觉得自己太傻;如果工具太糟,我们也会觉得自己很逊;而如果有人改进了工具,我们就会觉得体验很好,自己也很完美。”

格罗斯曼直接从人文的视角解释了为什么苹果的产品能够大受欢迎,头戴设备一直都未被大众所接受,交互环节的「麻烦」便占据了其中一个原因。乔布斯也曾在一次采访中谈到的一个故事,“一个6岁小男孩在未接触过iPad的情况下,仅凭直觉就可以用手指在屏幕上滑动,启动应用程序并玩游戏。”

如果头戴设备的交互能够简单到如此地步,还会很难推进大众市场?相信在两三年之后,将会见证Vision Pro能否成为下一代空间计算平台以及能否打开大众市场。

手眼语三种交互,一套系统,重新定义MR交互范式

其实,苹果每一次新品发布都会伴随交互方式的革新,如Mac的鼠标、iPhone的多触点功能、iPad的Apple Pencil再到如今的Vision Pro的眼球、手势与语音。可以说,正是因为有了每一次的交互革新,使用设备的潜能才真正被挖掘出来。

正如2005年乔布斯对微软一款平板电脑的评论“因为配有一支手写笔,这款产品就废了。”后来微软的平板电脑也确实被苹果颠覆了,不难看出好的交互设计对于用户而言多么重要。

一般人类是通过最基础的五官:眼(视觉)耳(听觉)鼻(嗅觉)舌(味觉)身(触觉)去感知世界。科技企业一直都在不断尝试模拟人类感知世界的五官,从而产生了各种各样的终端产品,只是一直仍未看到一款产品可以真正解决人机交互上存在的缺陷。Vision Pro的到来,极大满足了人们对人机交互的想象。为了能够很好理解Vision Pro的交互设计,以下将从眼动、手势与语音三方面进行拆解。

眼动追踪

眼动追踪一直都是AR/VR产业有待攻破的一大技术难题,近两年在很多新发布的AR/VR设备中已经可以看到,越来越多的产品搭载了眼动追踪技术,但整体体验上并不是很流畅,甚至有的都没有发挥这一技术的能力。

一方面,眼动追踪的交互方式与手柄的配合十分不完美,用户很难真正把手柄和眼动追踪联合起来运用。如果说叠加一项技术但又不能发挥这项技术的能力,那么就会让人觉得这项技术只有酷炫。另一面,眼动追踪对精准度的要求极高,如果技术不能做到及时捕捉眼睛的视线,就会导致定位不准,体验感极差。

眼动追踪技术研究的三大方向是眼球的注视点看向哪里、何时看、看多久,从而去捕捉用户情绪。在AR/VR设备中,眼动追踪的系统包含了近红外光源、高分辨率摄像头、以及图像处理相关的算法,三者缺一不可。

因此,能够真正把眼动追踪发挥好,底层技术很重要。近期陀螺君写了一篇《从Vision Pro一窥眼动追踪交互的巨大潜力》分析了苹果的眼动追踪技术,可点击详阅。

目前,大多数AR/VR设备采用的都是单芯片,在算法与图像处理方面的表现力匮乏。乔布斯就曾评价过英特尔的芯片设计,直指该芯片的图像处理方面太慢,应该有款芯片专门用来处理图像。

多年来,终于在Vision Pro这款产品看到了协处理芯片的设计。Vision Pro搭载M2与R1芯片,其中R1芯片为苹果全新设计,专为头显处理摄像头、传感器的数据传输(包括12个摄像头、5个传感器和6个麦克风的输入)。

据苹果表示:传输速率仅需12毫秒便可将内容同步到Vision Pro的屏幕上,几乎没有延迟,甚至可以达到比眨眼的时间快8倍,对比一下Meta的Quest 3就能够直观的感受到Vision Pro的装置是有多「豪」了。

Vision Pro与Quest3部分参数对比

为了能进一步提升注视点的准确性,苹果还为Vision Pro搭配了精心设计的UI,可以很好的辅助眼球追踪的功能。

从目前Vision Pro的参数与体验者的评价来看,Vision Pro在技术上完全做到了快与准,甚至都未看到有相关视线定位不准或视线抖动的情况。同时,其眼动追踪也做到了非常自然,用户的眼睛注视图标然后双指捏合,即可打开新的应用,眼睛在菜单栏停留一段时间会自动弹出二级菜单.......

眼动追踪虽并非苹果首创,但苹果却是首家将其作为核心交互方式的公司。不可否认,Vision Pro的到来打开了眼动追踪交互的潜力,更创新了眼睛+手势+语音的整套打法。

裸手交互

在AR/VR刚兴起时,业内就几乎确认了裸手交互是未来AR/VR的发展趋势,只是要想做好手势交互的确认度,是一项极大的技术难题。

也正由于技术的受限,裸手交互这一方式就一直都未被完整的发挥出来。手部是我们日常生活中交互信息的一个很重要环节,除了嘴巴之外,手部是最常用的信息输出肢体。

回看PC时代,即便最初会出现各种交互方式,最终都会落到鼠标、键盘,与手部相关的标准交互上。而发展下一代计算产品,手部交互仍很重要。在技术上未有突破的情况下,手柄是VR设备最好的交互方式,相较于裸手交互,手柄的准确度可以达到100%,尤其体现在玩游戏的过程中,所以现在大多数VR设备都采用手柄的交互方式。

此次苹果放弃了手柄这一外部操控器的交互方式,将裸手交互真正发挥了出来,展现了与市场上其他玩家完全不同的策略。也可以说,苹果意图用最便捷的交互方式打开轻度场景的应用,将产品更进一步地推向大众消费市场。

由于Vision Pro配备了四颗用于手势识别的摄像头,可以检测腰部以下的手势,用户还可以把手放在膝盖上进行操作,甚是轻松自如。

使用Vision Pro,双手可以自然搭在双腿上

除此之外,Vision Pro中的摄像头还能够非常精确地追踪眼睛视线,眼睛的位置是一个关键因素,可用于确定你想用手势进行互动的对象。例如,查看应用程序图标或虚拟元素会将其作为目标并高亮显示,然后你可以执行手势;或者想要打开的App,配合手部微小的动作就能完成操作。

还值得一提的是,Vision Pro已经可以实现虚拟键盘打字的方式。据了解,虚拟打字目前在触感上还未达到理想的状态,但苹果内部已经在着手优化了。

苹果实现虚拟键盘输入

在人机交互层面,苹果确实考虑到了用户体验的方方面面,苹果几乎将裸手交互发挥到了目前技术的极致,甚至让交互方式从科幻走入了现实,也让空间计算平台的发展前进了一大步。

智能语音

在ChatGPT未发布之前,人工智能技术的发展已经把语音交互提高到了可用的水平,而在ChatGPT发布之后,智能语音已经成为十分自然的事情了。

在我们日常生活中,智能设备的出现越发普遍,用户对语音的交互也更为熟悉。例如在智能家居中,天猫精灵、小度、苹果的Home再到智能手表与智能座舱,音频的实时交互几乎串联了我们所有生活的场景。

与此同时,淘宝、微信等APP的应用对语音输入的支持,都让智能的语音交互迸发出了旺盛的生命力。而作为下一代计算产品的AR/VR,语音交互必然也会成为其标配。而且实时互动语音技术也能让头戴设备的形态、用户体验产生质的飞跃。

苹果也将智能语音搭载进了头戴设备中,还可配合眼睛与手势进行交互。据称,在Vision Pro中你可以通过语音呼叫Siri,打开和关闭 App或者页面。VR陀螺近期也写了一篇文章,详细分析了Vision Pro中的AI应用,可以点击详阅《深剖Apple Vision Pro中暗藏的“AI”》。

Vision Pro中呼唤Siri

还值得一提的是,为了不使用户和周围的人隔绝,苹果还开发了一个名为Eyesight的反透视功能,这也是Vision Pro的一大基础交互设计。当有人在你附近时,设备看上去会是透明的,即让用户能够看到身边的人;而当你完全沉浸时,屏幕会暗下去,旁边的人也会明白此刻的你注意不到他们。

从目前各个方面信息来看,苹果完全创新了人机交互的方式,定义了头戴设备「眼睛+手势+语音」这一整套的交互标准,更为重要的是苹果将这套交互方式也找到了合理的应用场景,落在办公、视频、家居与观影上等轻度场景上,解决了交互方式与场景结合的难题。

Vision Pro的到来对头戴设备的影响就像初代iPhone的到来对手机市场的颠覆一般,或许并不会有初代iPhone那么受欢迎,但人机交互界面是时候该迎来下一场的发展了。

新一代空间计算产品,苹果正在重构AR/VR

库克将Vision Pro称为下一代空间计算产品,并不是AR/VR,不同于市面上完全追求沉浸感的VR产品,Vision Pro追求的是虚拟与现实的融合,让用户可以在体验沉浸感的同时也不会与外界隔离。

WWDC 2023大会期间,陆川与苹果副总裁展开了一番对话,其中特别令人印象深刻的是苹果副总裁对Vision Pro到来总结的三点,他说:

“第一,我们已经感觉到,一个科技划时代的时刻就要到来了。与其让别人来颠覆我们苹果,不如我们自己来。能颠覆苹果的,只有我们自己。”

“第二,我们感谢过去开发出的所有全系列苹果产品,因为它们挣回的这些钱。我们可以不计成本的去投入开发一个划时代的产品。我们干了六七年,就等今天。”

“第三,也要感谢其他的苹果产品,在这些产品的开发过程中。我们才能积累起足够强大的技术,最后把所有的科技,集成在Vision Pro这一个产品上。”

从他的回答中,能够看出苹果对新一代产品的重视程度,以及也解释了为什么这件事苹果可以做成。第一,苹果足够的有钱,2022年账面现金流就已过千亿;第二,苹果的技术累计足够的强,Vision Pro完全体现了这一点。

VR陀螺曾统计过,苹果从2010年左右就开始陆续收购或投资了多家面部识别、眼动追踪、空间定位、手势识别、动作捕捉等AR/VR相关的企业。

最终这些收购的企业技术都落在了Vision Pro上,例如苹果内部一直都认为头戴设备用控制器操控是个很「恼人的工具」,由此收购的多家面部追踪公司以及多个传感器公司,用多个传感器实时追踪人眼和手势让操作做到了更简单。

可以说是目前为止,Vision Pro是真正一款面向大众消费者的MR产品,你可以用它看电影、工作、娱乐、学习、联系家人/朋友等。

如何打通大众消费者,一直都是AR/VR努力的方向,但无奈多年来,无论是从硬件设计上还是场景应用上,AR/VR都未能吸引大众消费者的兴趣,这也是业内为什么会一直都觉得AR/VR缺杀手级应用的原因。

但使用的不便捷也是让诸多用户避而远之的一大因素,苹果到来或将会真正转变这一点。虽然从目前来看Vision Pro在价格与性能仍还有很多进步的空间,但Vision Pro确实让人感知到空间计算时代正在到来,站在虚拟与现实的融合发展上,Vision Pro标志了一个技术的新开端。

未来,随着苹果MR产品不断迭代,或许将会替代掉电脑、iPad与手机,实现万屏归一。